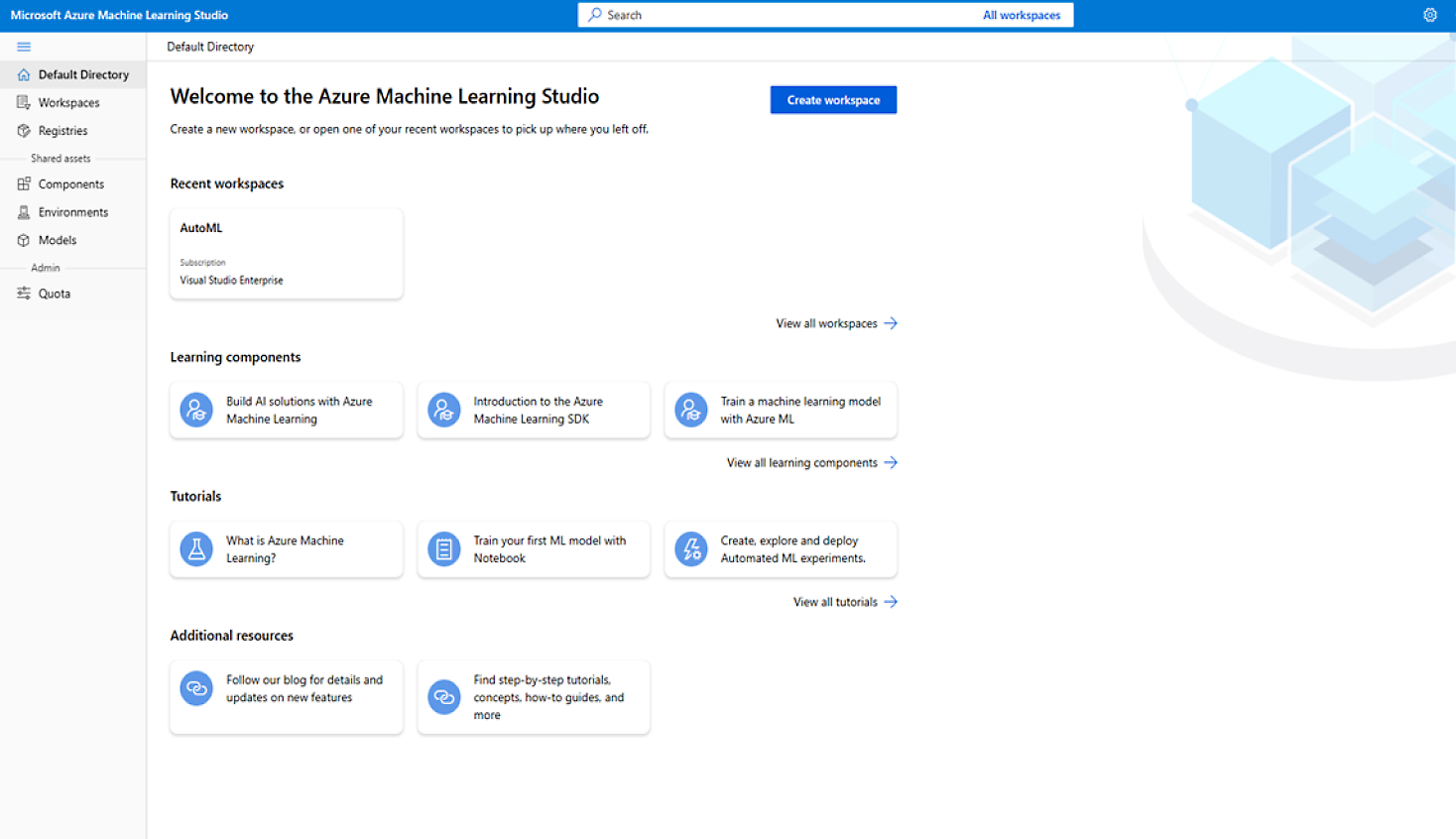

価値創出までの時間を短縮する

強力な AI インフラストラクチャ を活用して機械学習モデルを構築し、 プロンプト フローを使用して AI ワークフローを調整します。

MLOps の共同作業と効率化

ワークスペース間のコラボレーションと MLOps のための迅速な ML モデルのデプロイ、管理、共有

自信を持って開発する

機械学習ワークロードをどこでも実行するための組み込みのガバナンス、セキュリティ、コンプライアンス。

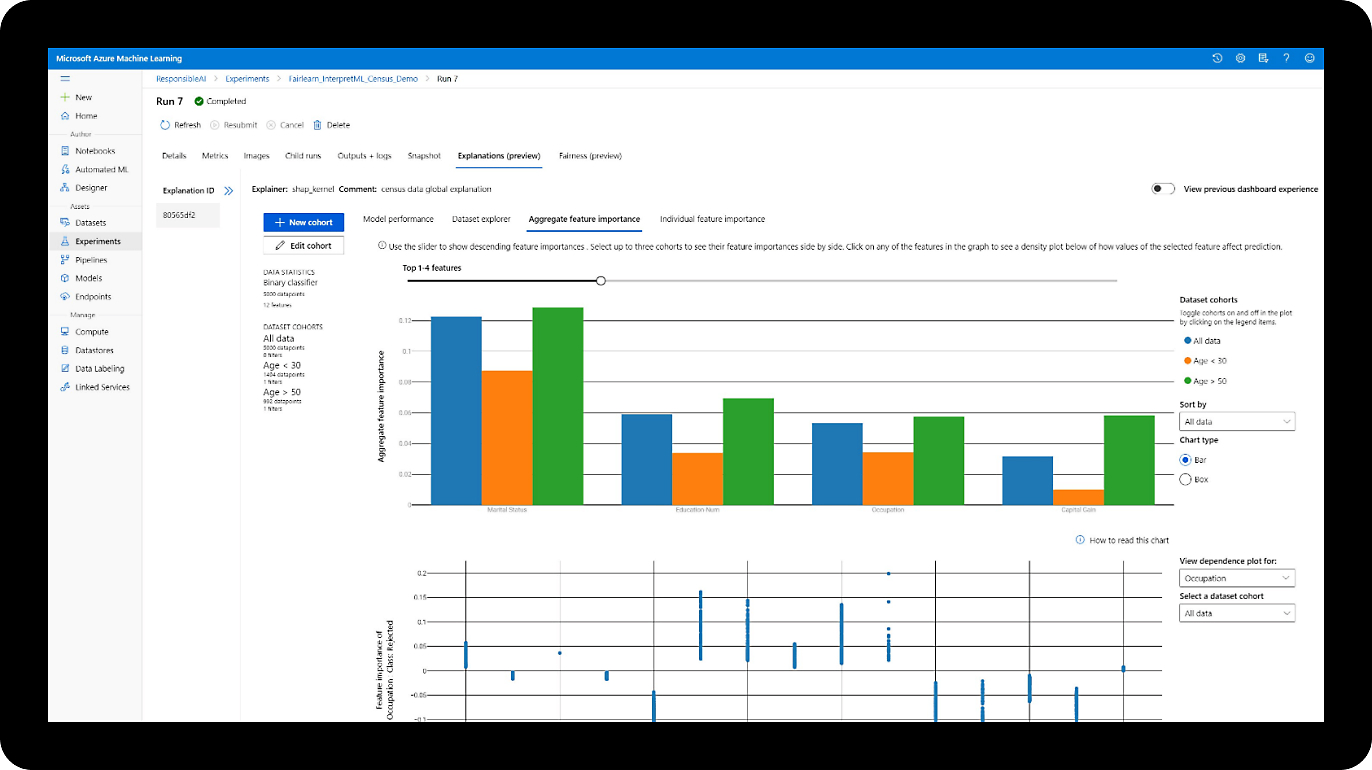

責任を持って設計する

透明性とアカウンタビリティに関するデータドリブンの決定を使用して説明可能なモデルを構築するための責任ある AI責任ある AI。

機械学習ライフサイクルをエンド ツー エンドでサポート

データのラベル付け

トレーニング データにラベルを付け、ラベル付けプロジェクトを管理します。

データ準備

データの探索と準備のために分析エンジンと一緒に使用します。

データセット

データにアクセスし、データセットを作成して共有します。

Notebooks

コンピューティングがアタッチされた共同 Jupyter ノートブックを使用します。

自動化された機械学習

正確な AI モデルを自動的にトレーニングして調整します。

ドラッグ アンド ドロップ デザイナー

ドラッグ アンド ドロップの開発インターフェイスを使用して設計します。

実験

実験を実行し、カスタム ダッシュボードを作成して共有します。

CLI および Python SDK

Azure コンピューティングでスケールアップおよびスケールアウトしながら、モデル トレーニング プロセスを加速します。

Visual Studio Code および GitHub

使い慣れた機械学習ツールを使用して、ローカル トレーニングからクラウド トレーニングに簡単に切り替えることができます。

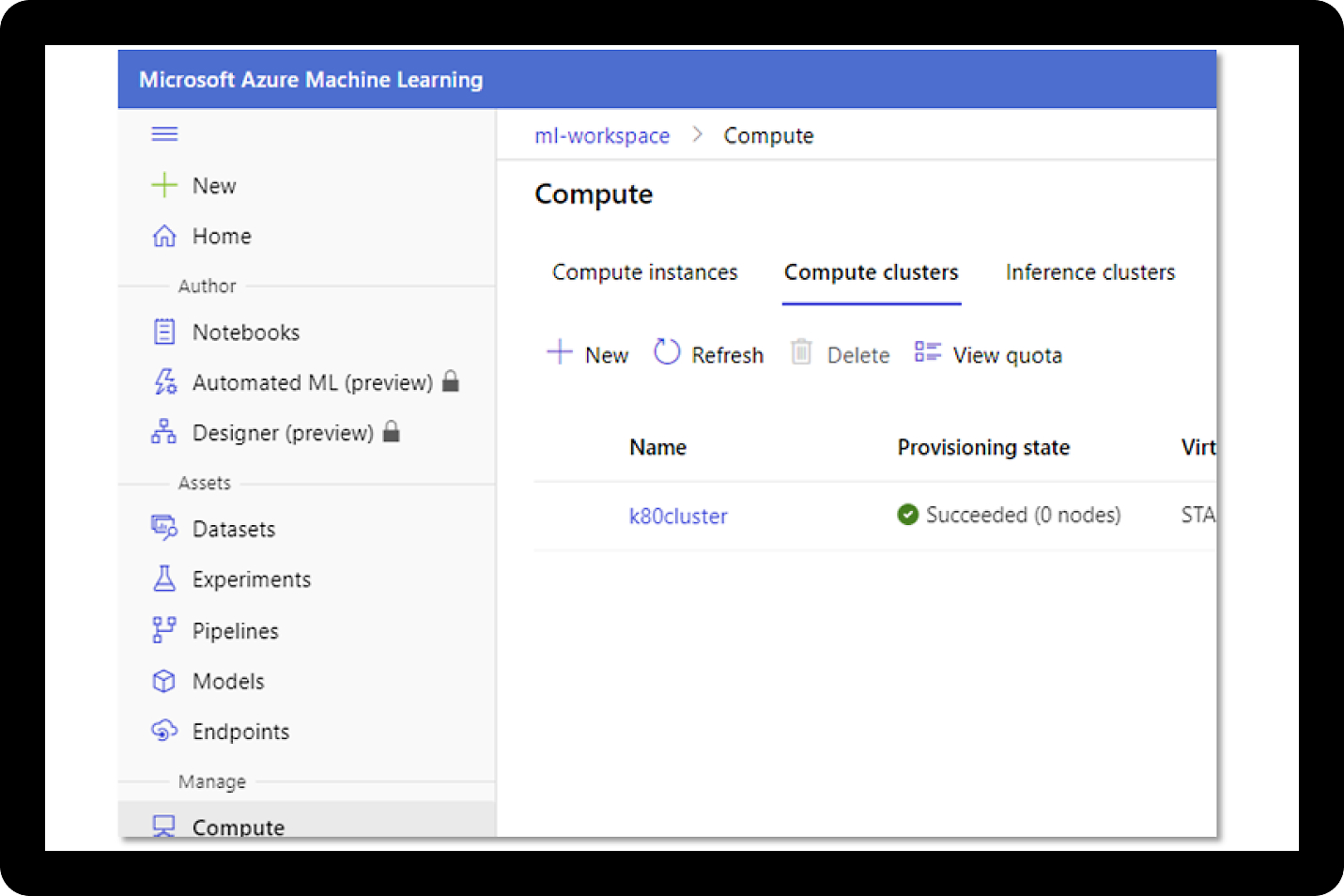

コンピューティング インスタンス

動的なスケーラビリティを備えた CPU、GPU、スーパーコンピューティング クラスターの安全なマネージド環境で開発できます。

オープンソースのライブラリとフレームワーク

Scikit-learn、PyTorch、TensorFlow、Keras、Ray RLLib などのサポートが組み込まれています。

マネージド エンドポイント

バッチおよびリアルタイムの推論用の AI 学習モデルを迅速かつ簡単にデプロイします。

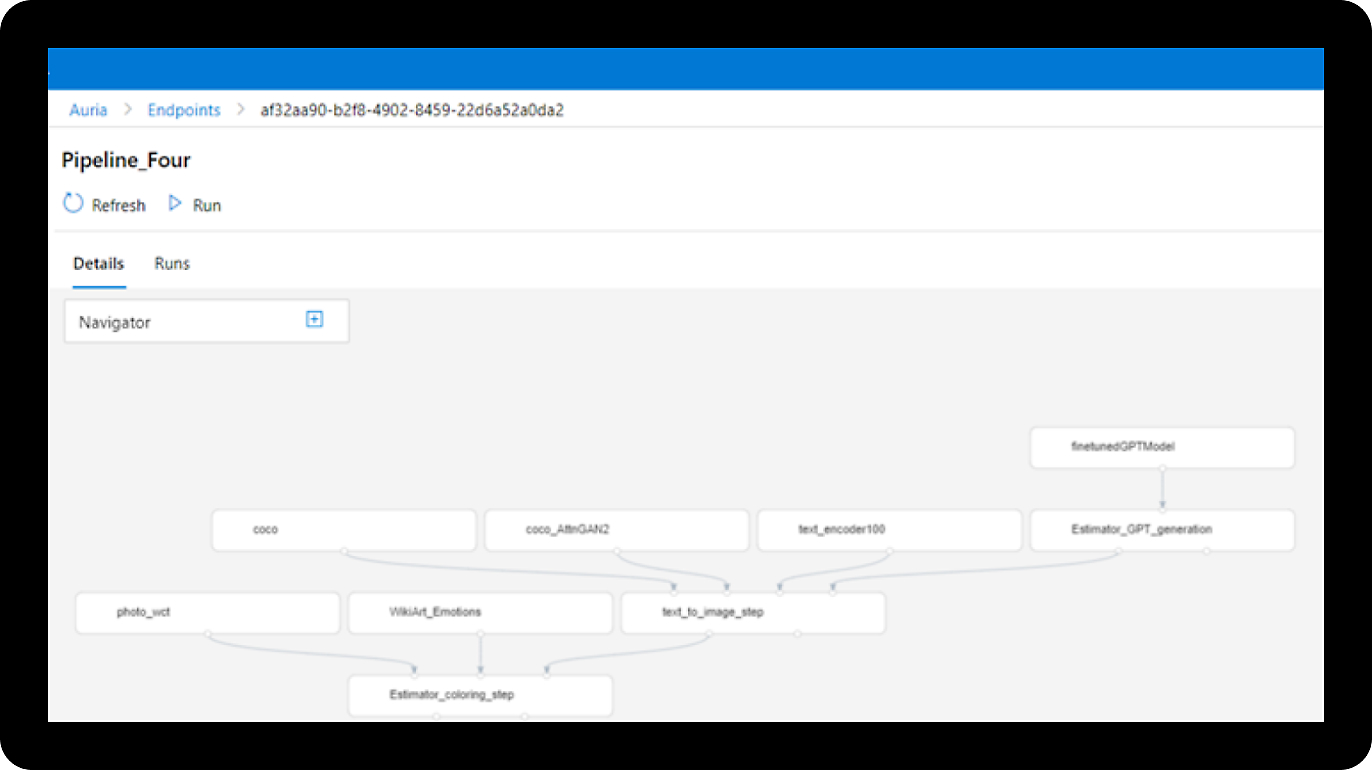

パイプラインと CI/CD

機械学習ワークフローを自動化します。

事前構築済みのイメージ

推論用のフレームワークとライブラリを使用してコンテナー イメージにアクセスします。

モデル リポジトリ

機械学習モデルとデータを共有して追跡します。

ハイブリッドとマルチクラウド

オンプレミスおよびマルチクラウド環境全体でモデルをトレーニングしてデプロイします。

最適化されたモデル

ONNX ランタイムを使用して、トレーニングと推論を加速し、コストを削減します。

レジストリ

組織内のチーム間でモデルとパイプラインを共有および検出します。

監視および分析

データ、モデル、リソースを追跡、記録、分析します。

データ ドリフト

ドリフトを検出し、モデルの精度を維持します。

エラー分析

モデルをデバッグし、AI モデルの精度を最適化します。

監査

コンプライアンスのために機械学習アーティファクトをトレースします。

ポリシー

コンプライアンス管理に組み込みポリシーとカスタム ポリシーを使用します。

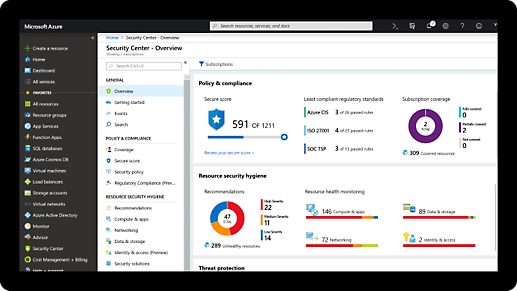

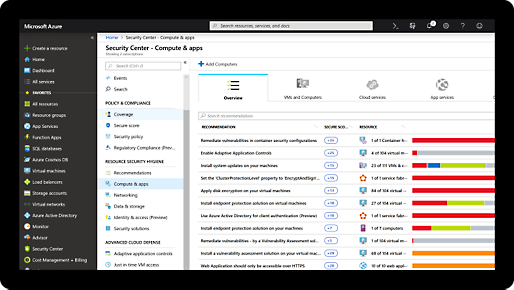

セキュリティ

Azure Security Center による継続的な監視をご利用ください。

コスト管理

クォータ管理と自動シャットダウンを適用します。

Azure Machine Learning for Generative AI

AI ワークフロー オーケストレーション

プロンプト フローを使用して、大規模な言語モデル–ベースのアプリケーションの設計、評価、デプロイを簡略化します。 さまざまなツールやリソースにわたるプロンプトとフローを簡単に追跡、再現、視覚化、および改善できます。Machine Learning における生成 AI の詳細をご覧ください。

マネージド エンド ツー エンド プラットフォーム

ネイティブ MLOps 機能で、大規模言語モデルのライフサイクルとモデル管理全体を効率化します。企業向け仕様のセキュリティにより、どこでも安全に機械学習を実行できます。責任ある AI のダッシュボードで、モデルのバイアス軽減やモデル評価ができます。

柔軟なツールとフレームワーク

PyTorch や TensorFlow などの柔軟なフレームワークを使用して、Visual Studio Code や Jupyter Notebook などのツールでディープ ラーニング モデルを構築します。Azure Machine Learning は、ONNX Runtime や DeepSpeed と互換性があり、トレーニングと推論の最適化が実現されています。

世界一流クラスのパフォーマンス

最新の NVIDIA GPU と InfiniBand ネットワーク ソリューションを最大 400 Gbps に組み合わせるために設計された、専用の AI インフラストラクチャを使用します。1 つのクラスター内で数千台もの GPU が稼働できるスケーラビリティにより、前例のないスケールに対応します。

迅速なモデル開発で価値実現までの時間を短縮

統一されたスタジオ エクスペリエンスを使用して生産性を向上させます。オープンソース フレームワークやライブラリのサポート機能を内蔵しており、Jupyter Notebook を使用してモデルをビルド、トレーニング、デプロイします。表形式、テキスト、画像データに対応した自動機械学習で、モデルをすばやく作成できます。Visual Studio Code を使用してローカル トレーニングからクラウド トレーニングへのシームレスな移行ができ、NVIDIA Quantum-2 InfiniBand プラットフォームによる Azure AI インフラストラクチャで自動スケーリングが可能です。プロンプト フローを使用して、大規模な言語モデルベースのアプリケーションのプロンプトを設計、比較、評価、デプロイします。

MLOps を使用したモデル管理の共同作業と効率化

ハイブリッド プラットフォームで企業向け仕様のソリューションを構築する

ライフサイクル全体で責任ある AI プラクティスを使用する

再現可能で自動化されたワークフローを使用して機械学習モデルを評価し、モデルの公平性、説明可能性、エラー分析、原因分析、モデル パフォーマンス、探索的データ分析を評価します。責任ある AI ダッシュボードで原因分析を使用して実際の介入を行い、デプロイ時にスコアカードを生成します。技術者と非技術者の両方に対して責任ある AI メトリクスを文脈によって解釈可能にして、利害関係者を巻き込み、コンプライアンス レビューを合理化します。

Azure を利用した機械学習のスキルを構築する

30 日間の学習体験を通じて、Azure での機械学習の詳細について学び、実践的なチュートリアルに参加できます。これを終えると、Azure Data Scientist Associate 認定資格を受ける準備ができていることになります。

機械学習ライフサイクル全体の主要なサービス機能

-

データ準備

Azure Databricks と相互運用可能な、Azure Machine Learning 内の Apache Spark クラスターで大規模なデータ準備をすばやく反復します。

-

機能ストア

マネージド機能ストアを使用して、複数のワークスペースにわたって機能の検出と再利用を可能にすることで、モデルの出荷の機敏性を高めます。

-

共同ノートブック

ノートブックを Jupyter Notebook または Visual Studio Code で起動すれば、デバッグや Git ソース コード管理のサポートなど、充実した開発環境を利用できます。

-

自動化された機械学習

自動機械学習を使用して分類、回帰、時系列予測、自然言語処理タスク、コンピューター ビジョン タスク用の正確なモデルを迅速に作成します。

-

レジストリ

組織全体のリポジトリ を使用して、複数のワークスペースでモデル、パイプライン、コンポーネント、データセットを保存および共有します。監査証跡機能を使用して、系統とガバナンス データをキャプチャします。

-

マネージド エンドポイント

マネージド エンドポイントを使用して、モデルのデプロイおよびスコアリングの運用、メトリックのログ記録、安全なモデルのロールアウトを行うことができます。

包括的なセキュリティとコンプライアンスの組み込み

-

Microsoft では、サイバーセキュリティの研究と開発に年間 USD10 億を超える投資を行っています。

-

Microsoft には、データ セキュリティとプライバシーを専門とする 3,500 人を超えるセキュリティ エキスパートがいます。

-

初期費用は不要で、料金は必要な分だけ発生

Azure 無料アカウントで作業を開始する

1

2

クレジットがなくなった後に、同じ無料サービスでビルドを続けるには、従量課金制に移行してください。月々の無料使用分を超えた場合にのみ、お支払いいただきます。

3

Azure Machine Learning リソース

IDC MarketScape:MLOps 2022 ベンダー評価

さまざまな業界の企業組織が MLOps を使用して、AI と機械学習テクノロジの実装に関する課題を克服する方法をご確認ください。

エンジニアリング MLOps に関するホワイト ペーパー

MLOps を使用して機械学習ソリューションを構築、デプロイ、監視するための体系的なアプローチを見つけます。実稼働環境に対応した機械学習ライフサイクルを大規模に迅速に構築、テスト、管理します。

Forrester Total Economic Impact 調査

Microsoft の委託による Forrester Consulting Total Economic ImpactTM 調査では、企業が Azure Machine Learning で実現できる潜在的な投資収益率を調査しています。

機械学習ソリューションに関するホワイト ペーパー

より安全かつスケーラブルで公正な機械学習ソリューションを構築する方法をご確認ください。

責任ある AI に関するホワイト ペーパー

より安全かつスケーラブルで公正な機械学習ソリューションを構築する方法をご確認ください。

MLOps ホワイト ペーパー

モデルを大規模に構築、トレーニング、デプロイするプロセスを加速します。

Azure Arc 対応機械学習に関するホワイト ペーパー

あらゆるインフラストラクチャでモデルを構築、トレーニング、デプロイする方法を学びます。