エンタープライズ規模でハイブリッド データ統合を簡素化する

フル マネージドのサーバーレス データ統合サービスである Azure Data Factory で、すべてのデータを統合しましょう。追加のコストなしでメンテナンス不要の 90 を超える組み込みのコネクタを使用して、データ ソースを視覚的に統合できます。ETL (抽出、変換、読み込み) と ELT (抽出、読み込み、変換) を簡単に構築し、直感的な環境でコードを含まないプロセスを行ったり、独自のコードを記述したりできます。その後、統合されたデータを Azure Synapse Analytics に提供して、ビジネスの分析情報を得ることができます。

使いやすい

組み込みの Git と継続的インテグレーションと継続的デリバリー (CI/CD) のサポートにより、ETL および ELT パイプラインをコードフリーで構築するための SQL Server Integration Services の簡単なリホスト。

コスト効率

従量課金制のフル マネージド サーバーレス クラウド サービスで、コスト効率の高いソリューションをオンデマンドでスケーリングできます。

強力

オンプレミスとサービスとしてのソフトウェア (SaaS) データをすべて取り込み、大規模に調整および監視するための 90 を超える組み込みコネクタ。

インテリジェント

自律 ETL を使用して運用効率を向上させ、市民インテグレーターを実現します。

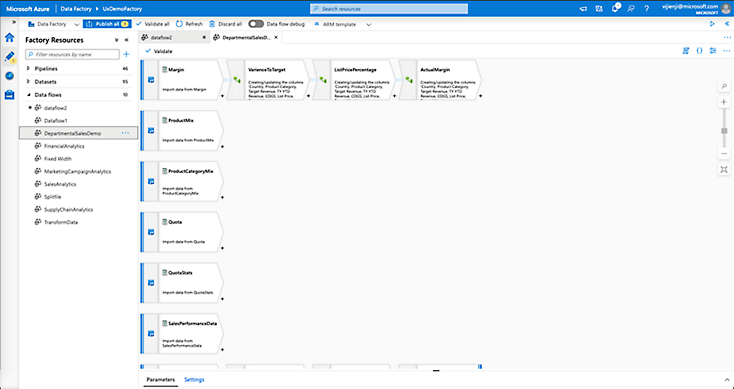

コードなしのデータ フローでデータ変換を高速化

デジタル トランスフォーメーションの取り組み全体で有効なデータ統合および変換レイヤーが Data Factory によって提供されます。

- 市民インテグレーターとデータ エンジニアがビジネスと IT 主導の Analytics/BI を推進できるようにします。

- データの準備、ETL および ELT プロセスの構築、パイプラインのオーケストレーションと監視をコードなしで行うことができます。コードの生成とメンテナンスは、マネージド Apache Spark™ サービスによって行われます。

- コピー アクティビティを自動化するインテリジェントなインテント駆動型マッピングによって、変換がより高速になります。

数回のクリックで SSIS をリホストおよび拡張

Azure Data Factory は SSIS の最新化を検討している組織に役立ちます。

- Azure ハイブリッド特典で最大 88% のコスト削減を実現します。

- すべての SSIS パッケージをクラウドに簡単に移動できる、完全に互換性のある唯一のデータ統合サービスをお楽しみください。

- デプロイ ウィザードや豊富な手引きのドキュメントがあるので移行は簡単です。

- Data Factory のクラウド データ パイプラインと組み合わせることによって、ハイブリッド ビッグ データとデータ ウェアハウスの取り組みに関するビジョンを実現できます。

組み込みのコネクタを使用してすべてのデータを取り込む

多様で複数のソースからデータを取り込むには、コストと時間がかかり、複数のソリューションが必要になる場合があります。Azure Data Factory では単一の従量課金制のサービスが提供されます。

- 90 を超える組み込みコネクタから選択して、Amazon Redshift、Google BigQuery、HDFS などのビッグ データ ソースからデータを取得します。Oracle Exadata や Teradata などのエンタープライズ データ ウェアハウス Salesforce、Marketo、ServiceNow などの SaaS アプリ。すべての Azure データ サービスを利用できます。

- 基になるネットワーク帯域幅の全容量 (最大 5 Gbps スループット) を使用します。

Azure Synapse Analytics を最大限に活用

オンプレミス、ハイブリッド、マルチクラウドのソースからデータを取り込んで、Data Factory を利用する Azure Synapse Analytics の強力なデータ フローで変換できます。

- Azure Synapse Pipelines 内の使い慣れた Data Factory エクスペリエンスでデータを統合および変換します。

- Azure Synapse Studio 内のデータ フローを使用して、コード不要でデータを変換および分析できます。

- 90 を超える組み込みコネクタとのデータ統合を実現します。

適切なデータによってアプリのエクスペリエンスを向上

Data Factory は、独立系ソフトウェア ベンダー (ISV) が統合されたハイブリッド データを使用して SaaS アプリを強化し、データドリブン のユーザー エクスペリエンスを提供するのに役立ちます。事前構築済みのコネクタと大規模なデータ統合は、ユーザーに集中するのに役立ち、Data Factoryは残りの処理を行います。

パイプラインのパフォーマンスの調整、監視、管理

急速に変化するデータランドスケープでパイプラインを維持すると、手動介入を伴う時間が急速に長くなる可能性があります。Azure Data Factory では、パイプラインを監視するアラートを事前に設定することで、すべてのアクティビティ実行を視覚的に監視し、運用の生産性を向上させます。これらのアラートは Azure のアラート グループ内で表示できるため、下流または上流の問題を発生前に防ぐために、事前に通知を確実に受けることができます。

シンプルになったハイブリッド データ統合

今日のデータドリブンの世界では、ビッグ データの処理は、すべての組織で重要な課題です。変革の分析情報を解き放つには、データ エンジニアは ETL を簡素化し、ビッグ データ統合の複雑さとスケールの課題に対処するために構築されたサービスが必要です。

Azure Data Factory を利用すると、コードフリーでも、コード中心でも ETL および ELT プロセスをすばやく簡単に構築できます。

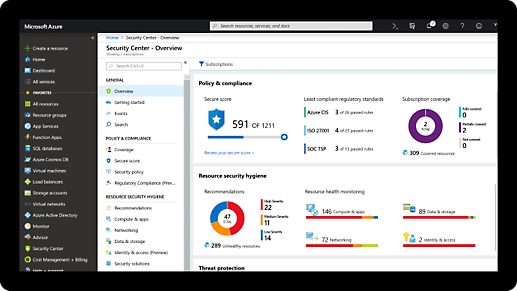

包括的なセキュリティとコンプライアンスの組み込み

-

Microsoft では、サイバーセキュリティの研究と開発に年間 USD10 億を超える投資を行っています。

-

Microsoft には、データ セキュリティとプライバシーを専門とする 3,500 人を超えるセキュリティ エキスパートがいます。

-

Azure は、他のあらゆるクラウド プロバイダーを上回る数の認定を受けています。包括的なリストをご確認ください。

-

初期費用は不要で、料金は必要な分だけ発生

スケール、インフラストラクチャ、互換性、パフォーマンス、予算のニーズに合う、さまざまなクラウド データ統合機能についてご紹介します。オプションとしては、SQL Server プロジェクトをクラウドにシームレスに移行するためのマネージド SSIS や、あらゆるシェイプおよびサイズのデータを統合するための大規模なサーバーレス データ パイプラインなどがあります。

Azure 無料アカウントで使用を開始する

1

2

クレジットがなくなった後に、同じ無料サービスでビルドを続けるには、従量課金制に移行してください。月々の無料使用分を超えた場合にのみ、お支払いいただきます。

3

Azure Data Factory のリソースとドキュメント

Azure Data Factory についてよく寄せられる質問

-

Data Factory は、 25 を超えるリージョンで利用できます。

-

Data Factory リソースに対する操作の実行要求を 99.9% 以上の時間、正常に処理することを保証します。スケジュールされたすべてのアクティビティの実行が 99.9% 以上の時間において、予定されている実行時刻の 4 分以内に開始されることも保証します。完全な Data Factory のサービス レベル アグリーメント (SLA) をお読みください。

-

統合ランタイムは、ネットワーク環境全体でデータ統合機能を提供するために使用 Data Factory コンピューティング インフラストラクチャです。統合ランタイムは、スケーラブルなデータ転送を提供することで、ソースとターゲットのデータ ストア間でデータを移動し、Spark コンピューティング ランタイム上でスケーラブルな方法で視覚的に作成された Data Flow を実行します。また、マネージド Azure コンピューティング環境で SSIS パッケージをネイティブに実行する機能も提供し、複数のコンピューティング サービスで実行されている変換アクティビティのディスパッチと監視をサポートします。詳細については、 Data Factory の統合ランタイムに関するページを参照してください。