Azure Data Lake incluye toda la funcionalidad necesaria para que los desarrolladores, analistas y científicos de datos puedan almacenar datos de cualquier tamaño, forma y velocidad de forma más fácil, de forma que puedan llevar a cabo todo tipo de procesamiento y análisis en diferentes plataformas y lenguajes. Elimina las complejidades que genera ingerir y almacenar la totalidad de los datos, a la vez que acelera la puesta en marcha y ejecución mediante análisis de lotes y de flujo de datos, así como otros análisis interactivos. Azure Data Lake funciona con inversiones existentes de TI en identidad, gobernanza y seguridad para simplificar la administración y gobernanza de datos. También se integra sin problemas con almacenes operativos y de datos, de forma que puedas extender las aplicaciones de datos actuales. Nos hemos inspirado en la experiencia de trabajar con clientes empresariales y ejecutar algunos de los procesos y análisis de mayor envergadura del mundo para empresas de Microsoft tales como Office 365, Xbox Live, Azure, Windows, Bing y Skype. Azure Data Lake resuelve muchos de los retos de productividad y escalabilidad que te impiden maximizar el valor de los recursos de datos mediante un servicio preparado para satisfacer tus necesidades de negocio actuales y futuras.

Azure Data Lake incluye toda la funcionalidad necesaria para que los desarrolladores, analistas y científicos de datos puedan almacenar datos de cualquier tamaño, forma y velocidad de forma más fácil, de forma que puedan llevar a cabo todo tipo de procesamiento y análisis en diferentes plataformas y lenguajes. Elimina las complejidades que genera ingerir y almacenar la totalidad de los datos, a la vez que acelera la puesta en marcha y ejecución mediante análisis de lotes y de flujo de datos, así como otros análisis interactivos. Azure Data Lake funciona con inversiones existentes de TI en identidad, gobernanza y seguridad para simplificar la administración y gobernanza de datos. También se integra sin problemas con almacenes operativos y de datos, de forma que puedas extender las aplicaciones de datos actuales. Nos hemos inspirado en la experiencia de trabajar con clientes empresariales y ejecutar algunos de los procesos y análisis de mayor envergadura del mundo para empresas de Microsoft tales como Office 365, Xbox Live, Azure, Windows, Bing y Skype. Azure Data Lake resuelve muchos de los retos de productividad y escalabilidad que te impiden maximizar el valor de los recursos de datos mediante un servicio preparado para satisfacer tus necesidades de negocio actuales y futuras.

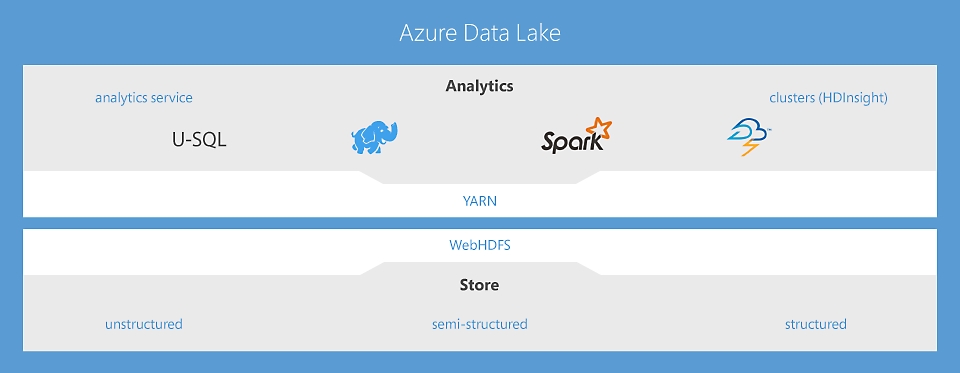

Data Lake Analytics: un servicio de trabajos de análisis sin límites que permite tomar medidas inteligentes

El primer servicio de análisis en la nube donde puedes desarrollar y ejecutar fácilmente programas de procesamiento y transformación de petabytes de datos con elevado paralelismo con los lenguajes U-SQL, R, Python y .Net. Procesa los datos a petición, modifica la escala de forma instantánea y paga solo por cada trabajo sin preocuparte de administrar la infraestructura. Más información

HDInsight: servicio de Apache Spark y Hadoop® en la nube para empresas

HDInsight es la única oferta de Hadoop en la nube totalmente administrada que proporciona clústeres de análisis de código abierto optimizados para Spark, Hive, Map Reduce, HBase, Storm, Kafka y R-Server, con el respaldo de un acuerdo de nivel de servicio del 99,9 %. Cada una de estas tecnologías de macrodatos, así como aplicaciones de fabricantes de software independientes, se pueden implementar fácilmente como clústeres administrados, con seguridad y supervisión de nivel empresarial. Más información

Data Lake Store: un lago de datos sin límites que permite llevar a cabo análisis de macrodatos

El primer lago de datos en la nube para empresas que es seguro, con escala modificable de forma masiva y que se ha creado conforme al estándar abierto HDFS. Al no tener límites en cuanto al tamaño de los datos y disponer de la capacidad para ejecutar análisis de elevado paralelismo, puedes sacar provecho de todos los datos no estructurados, semiestructurados y estructurados. Más información

Desarrollar, depurar y optimizar programas de macrodatos con facilidad

Buscar las herramientas adecuadas para diseñar y ajustar las consultas de macrodatos puede ser difícil. Data Lake te facilita el trabajo gracias a una integración completa con Visual Studio, Eclipse e IntelliJ que te permite usar herramientas que ya conoces para ejecutar, depurar y ajustar el código. Las visualizaciones de trabajos de U-SQL, Apache Spark, Apache Hive y Apache Storm te permiten ver cómo se ejecuta el código a gran escala e identificar cuellos de botella en el rendimiento y formas de optimizar el gasto, lo que facilita el ajuste de las consultas. Nuestro entorno de ejecución analiza de forma activa los programas a medida que se ejecutan y ofrece recomendaciones para mejorar el rendimiento y reducir el gasto. Los ingenieros de datos, administradores de bases de datos y arquitectos de datos pueden usar sus conocimientos en aplicaciones que ya conocen, como SQL, Apache Hadoop, Apache Spark, R, Python, Java y .NET, para ser más productivos desde el primer momento.

Integración sin problemas con las inversiones de TI existentes

Uno de los mayores retos de los macrodatos es la integración con inversiones de TI existentes. Data Lake es una parte fundamental de Cortana Intelligence que funciona con Azure Synapse Analytics, Power BI y Data Factory para ofrecer una plataforma completa de análisis avanzado y macrodatos en la nube que le ayuda en todo el proceso, desde la preparación de los datos hasta la realización de análisis interactivos en conjuntos de datos a gran escala. Con Data Lake Analytics, podrás actuar sobre todos sus datos con una virtualización optimizada de los orígenes relacionales, como Azure SQL Server en Virtual Machines, Azure SQL Database y Azure Synapse Analytics. Las consultas se optimizan automáticamente mediante el traslado de los procesos a una ubicación más cercana a los datos de origen, sin mover los datos, lo que maximiza el rendimiento y minimiza la latencia. Por último, dado que Data Lake se encuentra en Azure, puedes conectarte a cualquier conjunto de datos generado por aplicaciones o ingerido por dispositivos en escenarios de Internet de las cosas (IoT).

Almacenar y analizar archivos con tamaños en petabytes y billones de objetos

La arquitectura de Data Lake se ideó desde cero para optimizar la escalabilidad y rendimiento en la nube. Con Azure Data Lake Store, la organización puede analizar todos los datos en un único lugar sin restricciones artificiales. Data Lake Store puede almacenar billones de archivos donde un único archivo puede tener un tamaño de más de un petabyte, es decir, 200 veces más grande que lo permitido en otros almacenes en la nube. Esto significa que no tienes que reescribir código a medida que aumenta o disminuye el tamaño de los datos almacenados o la cantidad de procesos involucrados. Esto te permite centrarte únicamente en la lógica de negocios y no en cómo procesar y almacenar grandes conjuntos de datos. Data Lake también elimina las complejidades normalmente asociadas a macrodatos en la nube, lo cual garantiza que puedas satisfacer tus necesidades empresariales actuales y futuras.

Asequible y rentable

Data Lake es una solución rentable para la ejecución de cargas de trabajo de macrodatos. Puedes elegir entre clústeres a petición o un modelo de pago por trabajo cuando se procesen los datos. En ninguno de los casos se requiere hardware, licencias o contratos de soporte específicos de servicio. El sistema se escala o reduce verticalmente según las necesidades de la empresa, por lo que nunca pagarás más de lo que necesitas. También te permite modificar la escala del almacenamiento y los procesos independientemente, lo que permite una flexibilidad más económica que las soluciones de macrodatos tradicionales. Por último, minimiza la necesidad de contratar equipos de operaciones especializados, los cuales se suelen encargar de la administración de infraestructuras de macrodatos. Data Lake minimiza los gastos y maximiza la rentabilidad de la inversión de datos. Un estudio reciente demostró que, con HDInsight, el TCO es un 63 % más bajo que si se implementa Hadoop en el entorno local durante cinco años.

Seguridad, auditorías y soporte técnico de nivel empresarial

Data Lake es un servicio totalmente administrado por Microsoft, que también ofrece soporte técnico, y respaldado por un acuerdo de nivel de servicio empresarial. Disponemos de soporte técnico ininterrumpido. Puedes ponerte en contacto con nosotros para solucionar cualquier reto al que te enfrentes con tu solución de macrodatos. Nuestro equipo supervisa la implementación para que tú no tengas que hacerlo, y se asegura de que funcionará sin interrupciones. Data Lake protege los recursos de datos y extiende los controles de seguridad y gobernanza locales a la nube con facilidad. Los datos están siempre cifrados, ya sea en movimiento, con SSL o en reposo, mediante claves respaldadas con HSM y administradas por el usuario o el servicio en Azure Key Vault. Características como el inicio de sesión único (SSO), la autenticación multifactor y la administración fluida de millones de identidades se integran a través de Azure Active Directory. Puedes autorizar a usuarios y grupos con listas de control de acceso pormenorizadas basadas en POSIX para todos los datos del almacén al habilitar controles de acceso basados en rol. Finalmente, puedes satisfacer las necesidades de seguridad y cumplimiento normativo al auditar cada acceso o cambio de configuración en el sistema.

Crear soluciones de Data Lake mediante el uso de estas eficaces soluciones

HDInsight

Aprovisiona clústeres de Hadoop, Spark, R Server, HBase y Storm en la nube.

Data Lake Analytics

Servicio de análisis distribuido que facilita la observación de macrodatos.

Azure Data Lake Storage

Lago de datos escalable y seguro para análisis de alto rendimiento.