Azure Data Lake Storage

Lago de datos seguro y escalable de forma masiva para tus cargas de trabajo de análisis de alto rendimiento.

Crear una base para los análisis de alto rendimiento

Elimine los silos de datos con una sola plataforma de almacenamiento. Optimice los costos con almacenamiento en capas y administración de directivas. Autentique los datos mediante Microsoft Entra ID (anteriormente Azure Active Directory) y el control de acceso basado en rol (RBAC). Y ayude a proteger los datos con características de seguridad como el cifrado en reposo y la protección contra amenazas avanzada.

Escalabilidad ilimitada y una durabilidad de 16 9s de los datos con replicación geográfica automática

Almacenamiento de alta seguridad con mecanismos flexibles de protección para el acceso a los datos, el cifrado y el control de nivel de red

Plataforma de almacenamiento única para la ingesta, el procesamiento y la visualización que admite los marcos de análisis más comunes

Optimización de costes con el escalado independiente del almacenamiento y el proceso, administración de directivas del ciclo de vida y almacenamiento por niveles de los objetos individuales

Modifica la escala de la infraestructura para adaptarla a las cargas de trabajo de análisis más exigentes

Satisface los requisitos de capacidad y administra los datos fácilmente con la infraestructura global de Azure. Ejecuta consultas de análisis a gran escala con un alto rendimiento constante.

Utiliza mecanismos de seguridad flexibles

Protege el lago de datos con características que abarcan el cifrado, el acceso a los datos y el control de nivel de red, todo ello diseñado para ayudarte a generar información de una forma más segura.

Crea una base escalable para el análisis

Permite la ingesta de datos a gran escala con una amplia gama de herramientas para la ingesta de datos. Procesa los datos con Azure Databricks, Azure Synapse Analytics o Azure HDInsight. Y visualiza los datos con Microsoft Power BI para obtener información transformadora.

Crear lagos de datos en la nube rentables

Optimiza los costes con el escalado independiente de los recursos de proceso y almacenamiento, algo que no puedes hacer con los lagos de datos en el entorno local. Cambia a un nivel superior o inferior en función del uso y aprovecha las directivas automatizadas de administración del ciclo de vida para optimizar los costes de almacenamiento.

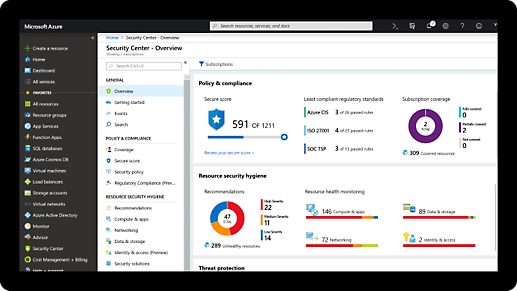

Seguridad y cumplimiento normativo completos e integrados

-

Microsoft invierte más de 1 000 000 000 USD al año en la investigación y el desarrollo de la ciberseguridad.

-

Contamos con más de 3500 expertos en seguridad que se dedican a proteger la seguridad y la privacidad de los datos.

Precios flexibles para la creación de lagos de datos

Elige entre las diferentes opciones de precios, incluidos los niveles, las reservas y la administración del ciclo de vida.

Comenzar con una cuenta gratuita de Azure

1

2

Después del crédito, cambia a un plan de pago por uso para seguir creando con los mismos servicios gratuitos. Pague solamente si su uso supera la cantidad gratuita mensual.

3

Avalado por compañías de todos los tamaños

"Con Azure, ahora tenemos la capacidad de impulsar rápidamente el valor de nuestros datos. La información útil de los modelos de datos que estamos creando nos ayudará a aumentar los ingresos, reducir los costes y minimizar el riesgo."

Ahmed Adnani, director de aplicaciones y análisis, Smiths Group

"Microsoft Azure nos ofrece un buen valor cuando necesitamos clústeres enormes durante un par de días para hacer un trabajo y luego nos permite deshacernos de ellos para ahorrar, mientras que usar un centro de datos es casi completamente inviable. Para nosotros ha sido un punto de inflexión enorme."

James Ferguson, director de productos, Marks & Spencer

Recursos para desarrolladores

Documentación de procedimientos

Preguntas más frecuentes sobre Data Lake Storage

-

Agregar el espacio de nombres jerárquico encima de los blobs permite conservar las ventajas económicas del almacenamiento en la nube sin comprometer las interfaces del sistema de archivos para las que se diseñaron los marcos de análisis de macrodatos.

Un ejemplo sencillo es un patrón que se produce con frecuencia de un trabajo de análisis que escribe los datos de salida en un directorio temporal y, después, le cambia el nombre al directorio para ponerle el nombre definitivo durante la fase de confirmación. En un almacén de objetos (que, por diseño, no admite la noción de directorios), estos cambios de nombre pueden ser operaciones largas que impliquen N operaciones de copia y eliminación, donde N es el número de archivos del directorio. Con el espacio de nombres jerárquico, estas operaciones de manipulación de directorios son atómicas, lo que mejora el rendimiento y el coste. Además, admitir directorios como elementos del sistema de archivos permite la aplicación de listas de control de acceso (ACL) conformes con POSIX que usan directorios primarios para propagar los permisos.

-

De forma similar a otros servicios de almacenamiento en la nube, Data Lake Storage se factura en función de la cantidad de datos almacenados más los costes de las operaciones realizadas en esos datos. Ver un desglose de los costes.

-

Data Lake Storage está diseñado principalmente para que funcione con Hadoop y con todos los marcos que usen Hadoop FileSystem como capa de acceso a los datos (por ejemplo, Spark y Presto). Consulte los detalles.

En Azure, Data Lake Storage es interoperable con:

- Azure Data Factory

- Azure HDInsight

- Azure Databricks

- Azure Synapse Analytics

- Power BI

El servicio también se incluye en el ecosistema de Azure Blob Storage.

-

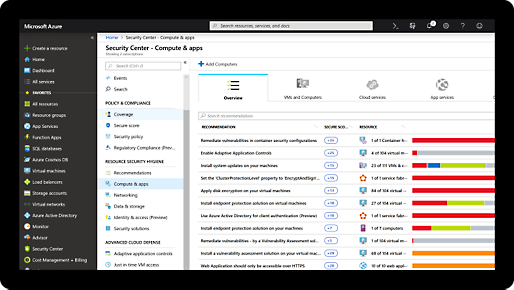

Data Lake Storage proporciona varios mecanismos para el control de acceso a los datos. Al ofrecer el espacio de nombres jerárquico, el servicio es el único almacén de análisis en la nube que incluye listas de control de acceso (ACL) conformes con POSIX, que constituyen la base de los permisos de Hadoop Distributed File System (HDFS). Data Lake Storage también incluye características de seguridad del nivel de transporte a través de firewalls de almacenamiento, puntos de conexión privados, la implementación de TLS 1.2 y el cifrado en reposo con claves suministradas por el cliente o por el sistema.