Tutorial: Verarbeiten von Apache Kafka für Event Hubs-Ereignisse mithilfe von Stream Analytics

Dieser Artikel zeigt, wie Daten an Event Hubs gestreamt und mit Azure Stream Analytics verarbeitet werden können. Die folgenden Schritte werden behandelt:

- Erstellen eines Event Hubs-Namespace

- Erstellen eines Kafka-Clients, der Nachrichten an den Event Hub sendet

- Erstellen eines Stream Analytics-Auftrags, der Daten aus dem Event Hub in Azure Blob Storage kopiert

Sie müssen Ihre Protokollclients nicht ändern oder eigene Cluster betreiben, wenn Sie den Kafka-Endpunkt verwenden, der von einem Event Hub verfügbar gemacht wird. Azure Event Hubs unterstützt Version 1.0 von Apache Kafka und höher.

Voraussetzungen

Für diese Schnellstartanleitung benötigen Sie Folgendes:

- Ein Azure-Abonnement. Wenn Sie keins besitzen, können Sie ein kostenloses Konto erstellen, bevor Sie beginnen.

- Java Development Kit (JDK) 1.7 oder höher

- Ein binäres Maven-Archiv (Download/Installationsanleitung)

- Git-Client

- Ein Azure Storage-Konto Wenn keine öffentliche IP-Adresse vorhanden ist, erstellen Sie jetzt eine, ehe Sie fortfahren. Der Stream Analytics-Auftrag in dieser exemplarischen Vorgehensweise speichert die Ausgabedaten in Azure Blob Storage.

Erstellen eines Event Hubs-Namespace

Wenn Sie einen Event Hubs-Namespace erstellen, wird der Kafka-Endpunkt für den Namespace automatisch aktiviert. Sie können Ereignisse von Ihren Anwendungen streamen, die das Kafka-Protokoll in Event Hubs verwenden. Befolgen Sie die Schritt-für-Schritt-Anleitung unter Erstellen eines Event Hubs mithilfe des Azure-Portals, um einen Event Hubs-Namespace zu erstellen. Wenn Sie einen dedizierten Cluster verwenden, finden Sie weitere Informationen unter Erstellen eines Namespace und eines Event Hubs in einem dedizierten Cluster.

Hinweis

Event Hubs für Kafka wird im Basic-Tarif nicht unterstützt.

Senden von Nachrichten mit Kafka in Event Hubs

Klonen Sie das Azure Event Hubs für Kafka-Repository auf Ihrem Computer.

Navigieren Sie zum Ordner

azure-event-hubs-for-kafka/quickstart/java/producer.Aktualisieren Sie die Konfigurationsdetails für die Producer in

src/main/resources/producer.config. Geben Sie den Namen und die Verbindungszeichenfolge des Event Hub-Namespace an.bootstrap.servers={EVENT HUB NAMESPACE}.servicebus.windows.net:9093 security.protocol=SASL_SSL sasl.mechanism=PLAIN sasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="$ConnectionString" password="{CONNECTION STRING for EVENT HUB NAMESPACE}";Navigieren Sie zu

azure-event-hubs-for-kafka/quickstart/java/producer/src/main/java/, und öffnen Sie die Datei TestDataReporter.java in einem Editor Ihrer Wahl.Kommentieren Sie die folgenden Codezeilen aus:

//final ProducerRecord<Long, String> record = new ProducerRecord<Long, String>(TOPIC, time, "Test Data " + i);Fügen Sie anstelle des auskommentierten Codes die folgende Codezeile hinzu:

final ProducerRecord<Long, String> record = new ProducerRecord<Long, String>(TOPIC, time, "{ \"eventData\": \"Test Data " + i + "\" }");Dieser Code sendet die Ereignisdaten im JSON-Format. Wenn Sie die Eingabe für einen Stream Analytics-Auftrag konfigurieren, geben Sie JSON als Format für die Eingabedaten an.

Führen Sie den Producer aus, und streamen Sie Daten an Event Hubs. Wechseln Sie auf einem Windows-Computer bei Verwendung einer Node.js-Eingabeaufforderung zum Ordner

azure-event-hubs-for-kafka/quickstart/java/producer, bevor Sie diese Befehle ausführen.mvn clean package mvn exec:java -Dexec.mainClass="TestProducer"

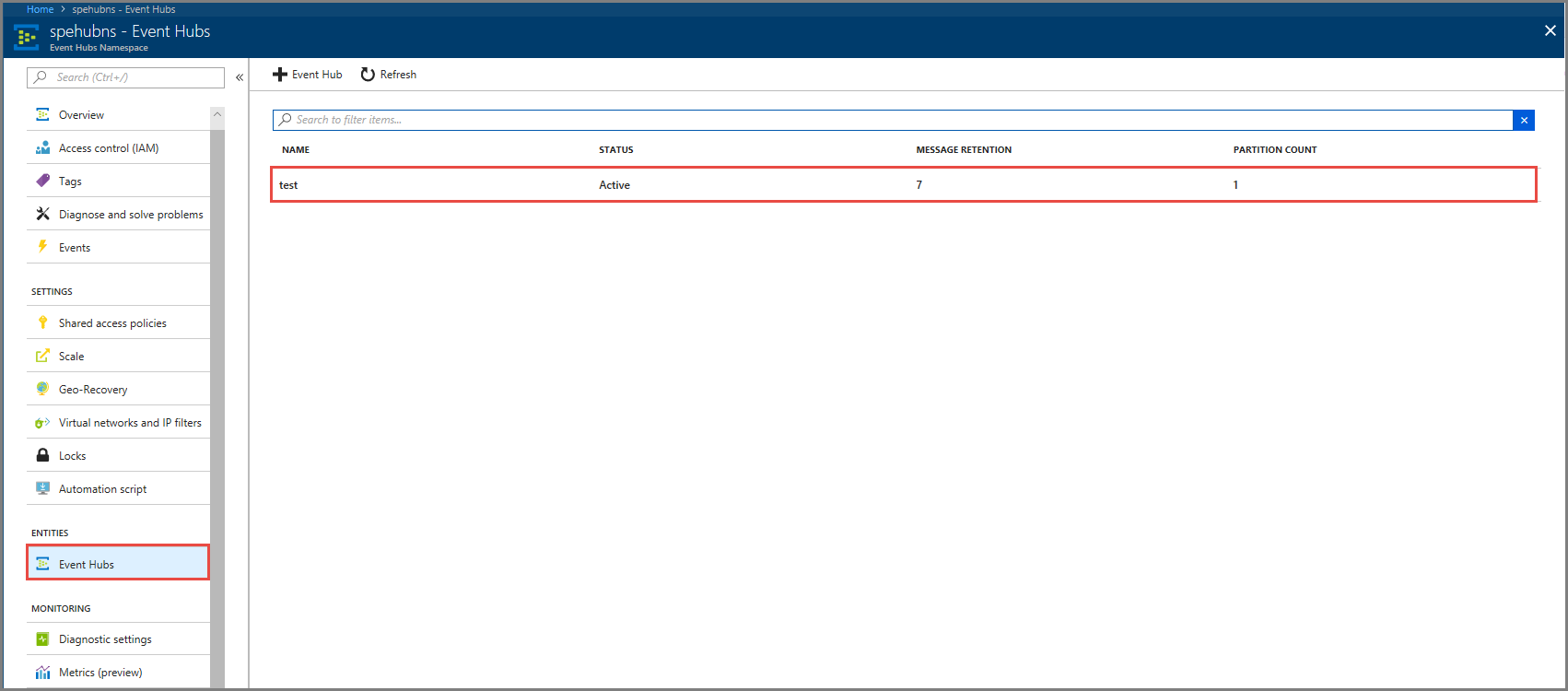

Sicherstellen, dass der Event Hub die Daten empfängt

Wählen Sie unter ENTITÄTEN die Option Event Hubs aus. Bestätigen Sie, dass ein Event Hub mit dem Namen test angezeigt wird.

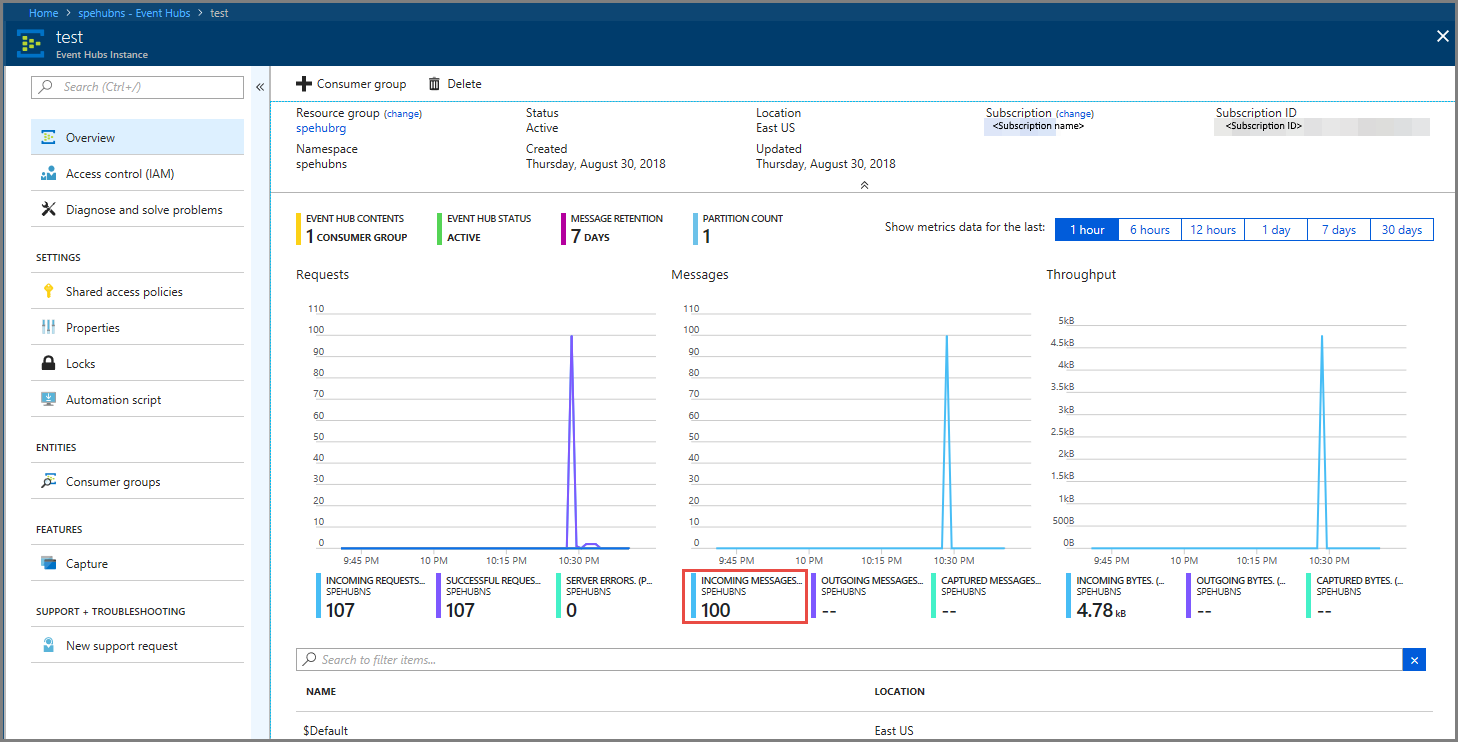

Bestätigen Sie, dass im Event Hub Nachrichten eingehen.

Verarbeiten von Ereignisdaten mithilfe eines Stream Analytics-Auftrags

In diesem Abschnitt erstellen Sie einen Azure Stream Analytics-Auftrag. Der Kafka-Client sendet Ereignisse an den Event Hub. Sie erstellen einen Stream Analytics-Auftrag, der Ereignisdaten als Eingabe verwendet und diese in Azure Blob Storage ausgibt. Wenn Sie über kein Azure Storage-Konto verfügen, müssen Sie eines erstellen.

Die Abfrage im Stream Analytics-Auftrag durchläuft die Daten, ohne eine Analyse vorzunehmen. Sie können eine Abfrage erstellen, die die Eingabedaten transformiert, um Ausgabedaten in einem anderen Format oder mit gewonnenen Erkenntnissen zu erzeugen.

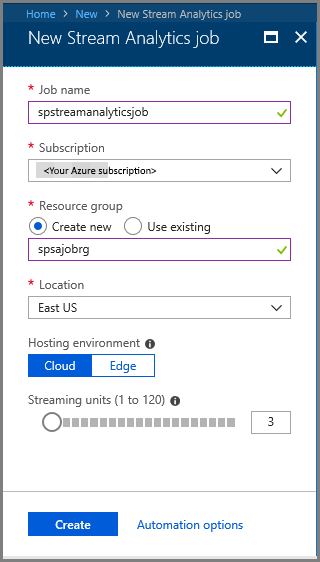

Erstellen eines Stream Analytics-Auftrags

- Klicken Sie im Azure-Portal auf + Ressource erstellen.

- Wählen Sie Analytics im Menü Azure Marketplace und dann Stream Analytics-Auftrag aus.

- Gehen Sie auf der Seite Neuer Stream Analytics-Auftrag wie folgt vor:

Geben Sie einen Namen für den Auftrag ein.

Wählen Sie Ihr Abonnementaus.

Klicken Sie für die Ressourcengruppe auf Neu erstellen, und geben Sie den Namen ein. Sie können auch eine vorhandene Ressourcengruppe verwenden.

Wählen Sie einen Speicherort für den Auftrag aus.

Klicken Sie auf Erstellen, um den Auftrag zu erstellen.

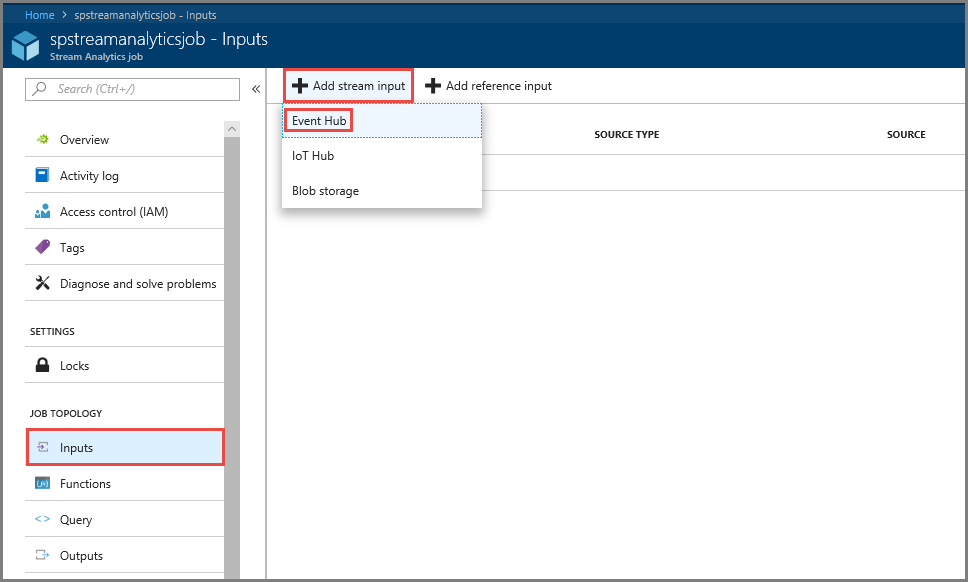

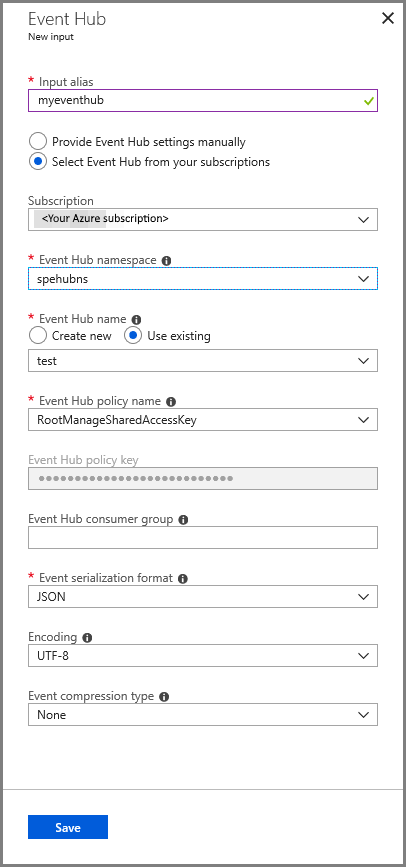

Konfigurieren einer Auftragseingabe

Wählen Sie in der Benachrichtigungsmeldung Zur Ressource wechseln aus, um die Seite Stream Analytics-Auftrag einzublenden.

Wählen Sie im Abschnitt AUFTRAGSTOPOLOGIE im linken Menü Eingaben aus.

Klicken Sie auf Datenstromeingabe hinzufügen, und wählen Sie Event Hub aus.

Führen Sie auf der Konfigurationsseite Event Hub-Eingabe die folgenden Schritte aus:

Geben Sie einen Alias für die Eingabe an.

Wählen Sie Ihr Azure-Abonnement aus.

Wählen Sie den Event Hub-Namespace aus, den Sie zuvor erstellt haben.

Wählen Sie test als Event Hub aus.

Wählen Sie Speichern aus.

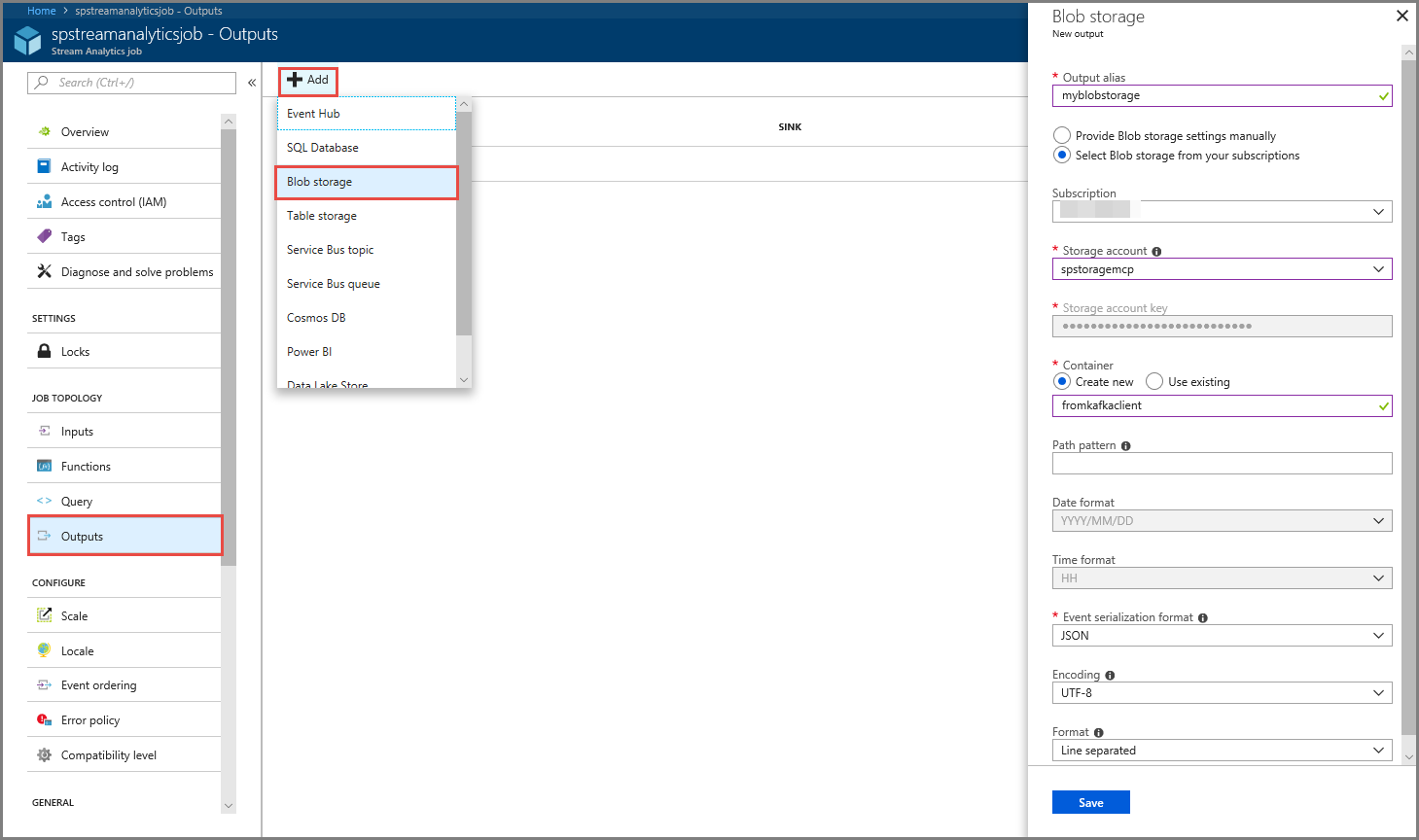

Konfigurieren der Auftragsausgabe

- Wählen Sie im Abschnitt AUFTRAGSTOPOLOGIE im linken Menü Ausgaben aus.

- Klicken Sie auf der Symbolleiste auf + Hinzufügen, und wählen Sie Blob Storage aus.

- Gehen Sie auf der Seite mit den Blob Storage-Ausgabeeinstellungen folgendermaßen vor:

Geben Sie einen Alias für die Ausgabe an.

Wählen Sie Ihr Azure- Abonnementaus.

Wählen Sie Ihr Azure Storage-Konto aus.

Geben Sie einen Namen für den Container ein, in dem die Ausgabedaten der Stream Analytics-Abfrage gespeichert werden.

Wählen Sie Speichern aus.

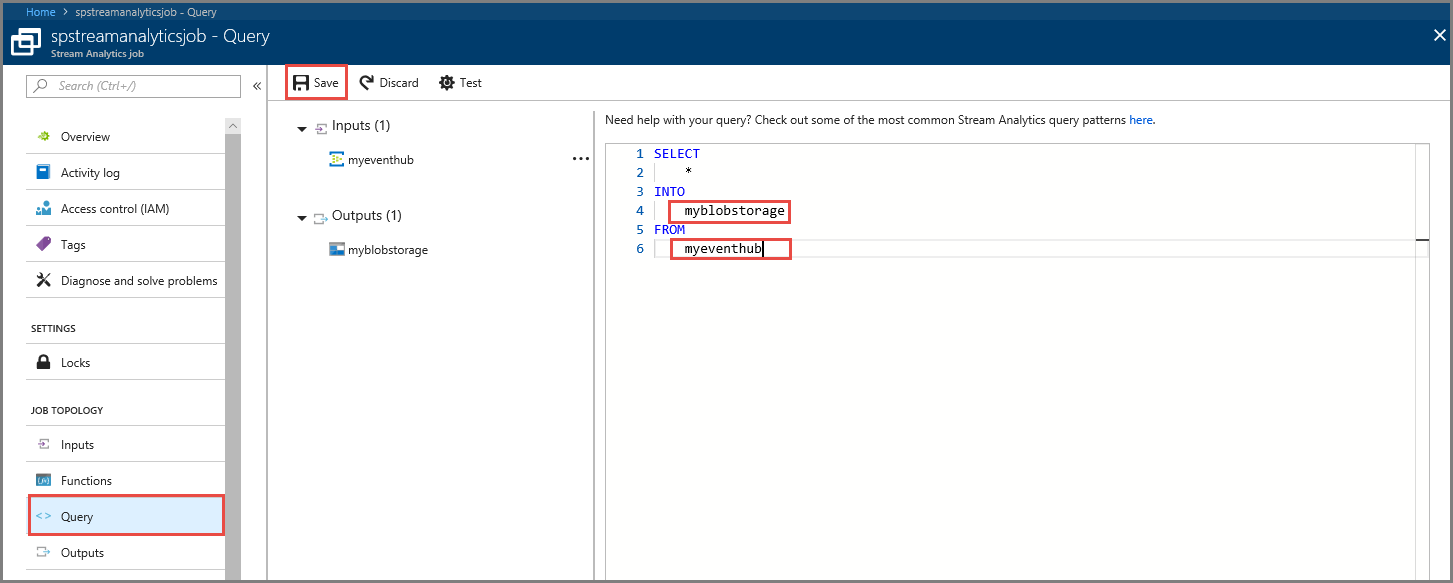

Definieren einer Abfrage

Nachdem Sie einen Stream Analytics-Auftrag eingerichtet haben, um einen eingehenden Datenstrom zu lesen, ist der nächste Schritt die Erstellung einer Transformation, bei der Daten in Echtzeit analysiert werden. Sie definieren die Transformationsabfrage mit der Stream Analytics-Abfragesprache. In dieser exemplarischen Vorgehensweise definieren Sie eine Abfrage, die die Daten ohne jegliche Transformation durchläuft.

Wählen Sie Abfrage.

Ersetzen Sie im Abfragefenster

[YourOutputAlias]durch den Ausgabealias, den Sie zuvor erstellt haben.Ersetzen Sie

[YourInputAlias]durch den Eingabealias, den Sie zuvor erstellt haben.Wählen Sie auf der Symbolleiste Speichern aus.

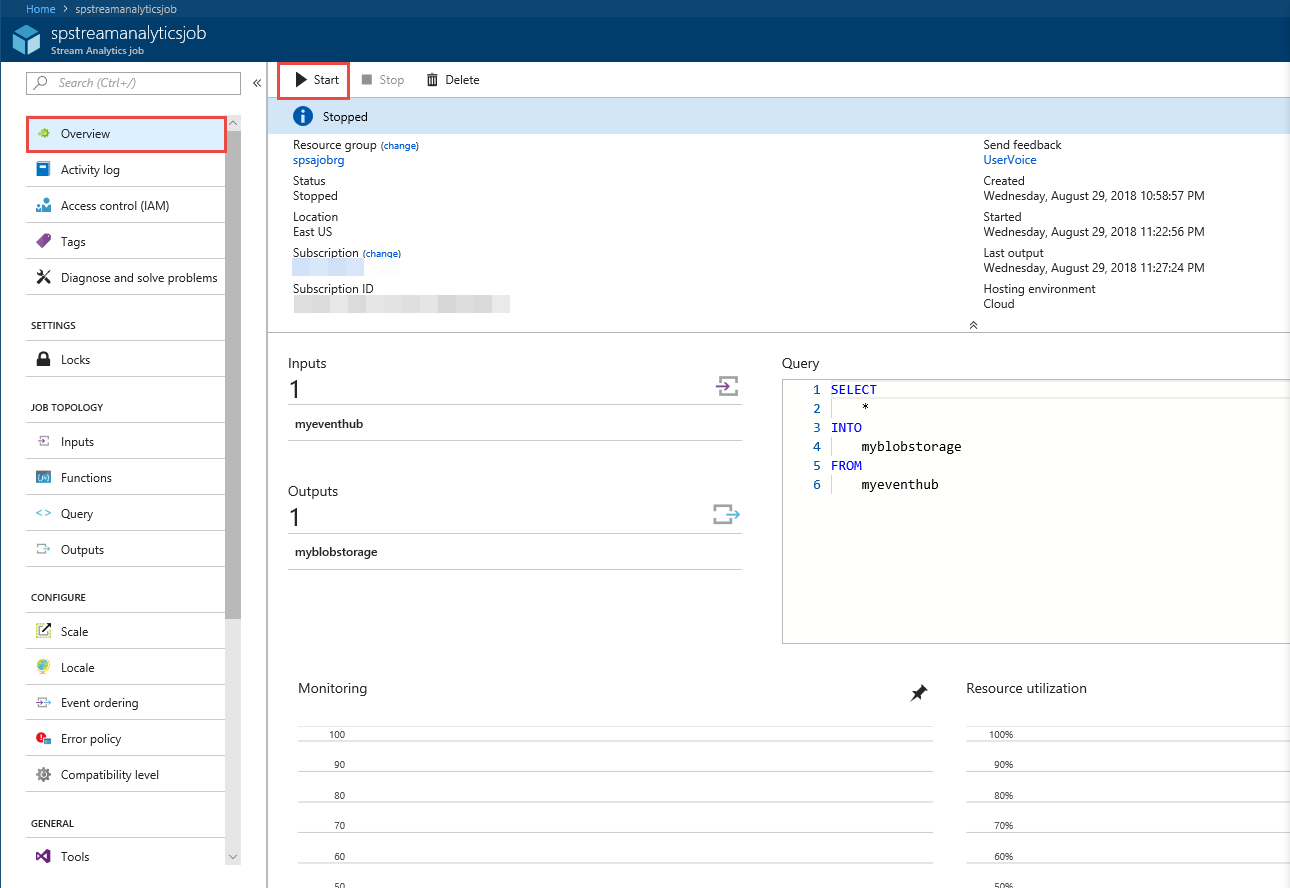

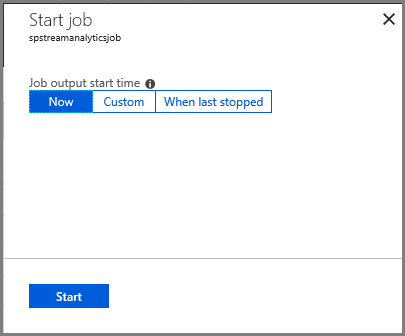

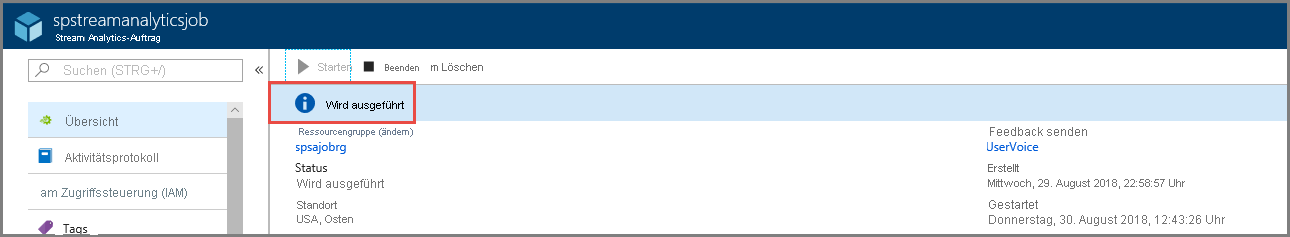

Ausführen des Stream Analytics-Auftrags

Klicken Sie im linken Menü auf Übersicht.

Wählen Sie Starten aus.

Klicken Sie auf der Seite Auftrag starten auf Jetzt.

Warten Sie, bis sich der Status des Auftrags von Wird gestartet in Wird ausgeführt ändert.

Prüfen des Szenarios

Führen Sie die Kafka Producer erneut aus, um Ereignisse an den Event Hub zu senden.

mvn exec:java -Dexec.mainClass="TestProducer"Überprüfen Sie, ob Ausgabedaten in Azure Blob Storage generiert werden. Sie sehen im Container eine JSON-Datei mit 100 Zeilen, die wie die folgenden Beispielzeilen aussehen:

{"eventData":"Test Data 0","EventProcessedUtcTime":"2018-08-30T03:27:23.1592910Z","PartitionId":0,"EventEnqueuedUtcTime":"2018-08-30T03:27:22.9220000Z"} {"eventData":"Test Data 1","EventProcessedUtcTime":"2018-08-30T03:27:23.3936511Z","PartitionId":0,"EventEnqueuedUtcTime":"2018-08-30T03:27:22.9220000Z"} {"eventData":"Test Data 2","EventProcessedUtcTime":"2018-08-30T03:27:23.3936511Z","PartitionId":0,"EventEnqueuedUtcTime":"2018-08-30T03:27:22.9220000Z"}Der Azure Stream Analytics-Auftrag hat in diesem Szenario Eingabedaten vom Event Hub empfangen und diese in Azure Blob Storage gespeichert.

Nächste Schritte

In diesem Artikel haben Sie erfahren, wie Daten an Event Hubs gestreamt werden, ohne dass Sie Protokollclients ändern oder eigene Cluster ausführen müssen. Weitere Informationen zu Event Hubs für Apache Kafka finden Sie unter Apache Kafka-Entwicklerleitfaden für Azure Event Hubs.