Übersicht und Architektur der SAP CDC-Funktionen

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

Hier finden Sie Informationen zu den Funktionen von SAP Change Data Capture (CDC) in Azure Data Factory sowie zur Architektur.

Azure Data Factory ist eine ETL- und ELT-Datenintegrationsplattform als Dienst (PaaS). Für die SAP-Datenintegration bietet Data Factory derzeit sechs allgemeine Verfügbarkeitskonnektoren:

Anforderungen für die Datenextraktion

Die SAP-Konnektoren in Data Factory extrahieren SAP-Quelldaten nur in Batches. Jeder Batch verarbeitet vorhandene und neue Daten gleichermaßen. In der Datenextraktion im Batchmodus werden Änderungen zwischen vorhandenen und neuen Datasets nicht identifiziert. Diese Art von Extraktionsmodus ist nicht optimal, wenn Sie große Datasets wie Tabellen haben, die Millionen oder Milliarden von Datensätzen enthalten, die häufig geändert werden.

Sie können Ihre Kopie von SAP-Daten frisch und auf dem neuesten Stand halten, indem Sie häufig das vollständige Dataset extrahieren, aber dieser Ansatz ist teuer und ineffizient. Sie können auch eine manuelle, eingeschränkte Problemumgehung verwenden, um hauptsächlich neue oder aktualisierte Datensätze zu extrahieren. In einem Prozess namens Wasserzeichenerstellung erfordert die Extraktion eine Zeitstempelspalte, monoton steigende Werte und die kontinuierliche Verfolgung des höchsten Werts seit der letzten Extraktion. Einige Tabellen verfügen jedoch nicht über eine Spalte, die Sie für das Watermarking verwenden können. Dieser Prozess identifiziert außerdem einen gelöschten Datensatz nicht als Änderung im Dataset.

SAP CDC-Funktionen

Microsoft-Kunden haben angegeben, dass sie einen Konnektor benötigen, der nur das Delta zwischen zwei Datensätzen extrahieren kann. Bei Daten ist ein Delta jede Änderung in einem Dataset, die das Ergebnis eines Updates, Einfügens oder Löschens im Dataset ist. Ein Delta-Extraktionskonnektor verwendet das Feature „SAP Change Data Capture (CDC), das in den meisten SAP-Systemen vorhanden ist, um das Delta in einem Dataset zu bestimmen. Die SAP CDC-Funktionen in Data Factory verwenden das SAP ODP-Framework (Operational Data Provisioning), um das Delta in einem SAP-Quelldataset zu replizieren.

In diesem Artikel wird eine allgemeine Architektur der SAP CDC-Funktionen in Azure Data Factory behandelt. Weitere Informationen zu den SAP CDC-Funktionen finden Sie unter:

- Voraussetzungen und Setup

- Einrichten einer selbstgehosteten Integrationslaufzeit

- Einrichten eines verknüpften Diensts und Quelldatasets

- Verwalten Ihrer Lösung

Verwenden der SAP CDC-Funktionen

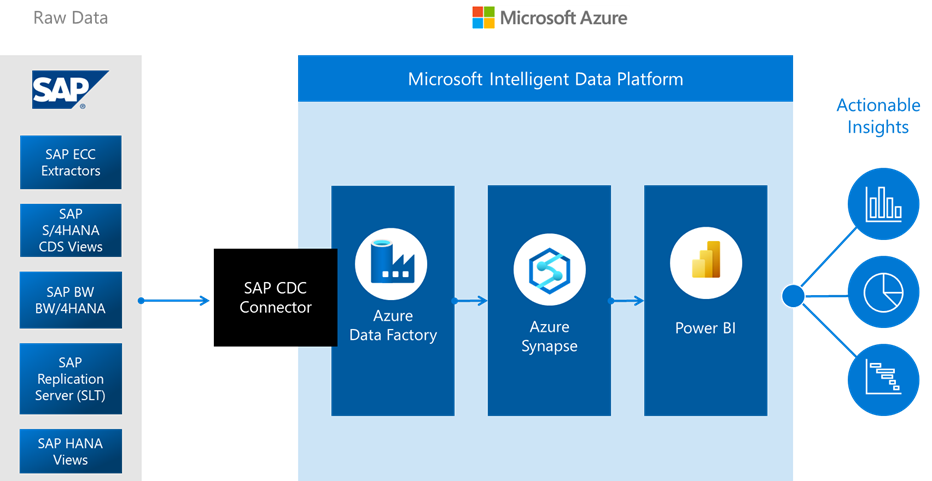

Der SAP CDC-Connector ist der Kern der SAP CDC-Funktionen. Er kann eine Verbindung mit allen SAP-Systemen herstellen, die ODP unterstützen, einschließlich SAP ECC, SAP S/4HANA, SAP BW und SAP BW/4HANA. Die Lösung funktioniert entweder direkt auf der Anwendungsebene oder indirekt über einen SAP Landscape Transformation Replikation Server (SLT) als Proxy. Sie nutzt keine Wasserzeichen, um SAP-Daten vollständig oder inkrementell zu extrahieren. Die Daten, die der SAP CDC-Connector extrahiert, umfassen nicht nur physische Tabellen, sondern auch logische Objekte, die durch die Verwendung der Tabellen erstellt werden. Ein Beispiel für ein tabellenbasiertes Objekt ist eine Core Data Services- (CDS) Ansicht des SAP Advanced Business Application Programming (ABAP).

Verwenden Sie den SAP CDC-Connector mit Data Factory-Features wie Zuordnungsdatenfluss-Aktivitäten sowie Trigger mit rollierendem Fenster für eine latenzarme SAP CDC-Replikationslösung in einer selbst verwalteten Pipeline.

Die SAP CDC-Architektur

Die SAP CDC-Lösung in Azure Data Factory ist ein Konnektor zwischen SAP und Azure. Die SAP-Seite enthält den SAP ODP-Connector, der die ODP-API über standardmäßige RFC-Module (Remote Function Call) aufruft, um SAP-Rohdaten (vollständig und Deltas) zu extrahieren.

Die Azure-Seite umfasst den Zuordnungsdatenfluss, der die SAP-Daten transformieren und in eine beliebige Datensenke laden kann, die von Zuordnungsdatenflüssen unterstützt wird. Einige dieser Optionen sind Speicherziele wie Azure Data Lake Storage Gen2 oder Datenbanken wie Azure SQL-Datenbank und Azure Synapse Analytics. Die Zuordnungsdatenflussaktivität kann die Ergebnisse auch im Delta-Format in Data Lake Storage Gen2 laden. Sie können das Delta Lake-Zeitreisefeature verwenden, um Momentaufnahmen von SAP-Daten für einen bestimmten Zeitraum zu erstellen. Sie können Ihre Pipeline und Ihre Zuordnungsdatenflüsse häufig ausführen, indem Sie einen Data Factory-Trigger mit rollierendem Fenster verwenden, um SAP-Daten in Azure mit geringer Latenz und ohne Wasserzeichen zu replizieren.

Erstellen Sie für den Einstieg zunächst einen mit SAP CDC verknüpften Dienst, ein SAP CDC-Quelldataset und eine Pipeline mit einer Zuordnungsdatenflussaktivität, in der das SAP CDC-Quelldataset verwendet wird. Zum Extrahieren der Daten aus SAP ist eine selbstgehostete Integration Runtime erforderlich, die Sie auf einem lokalen Computer oder auf einem virtuellen Computer (VM) installieren, der eine Sichtverbindung zu Ihren SAP-Quellsystemen oder Ihrem SLT-Server aufweist. Die Zuordnungsdatenflussaktivität wird auf einem serverlosen Azure Databricks- oder Apache Spark-Cluster oder in einer Azure-Integration Runtime ausgeführt. Es muss ein Stagingspeicher in der Zuordnungsdatenflussaktivität konfiguriert werden, damit die selbstgehostete Integration Runtime nahtlos mit der Zuordnungsdatenfluss-Integration Runtime zusammenarbeitet.

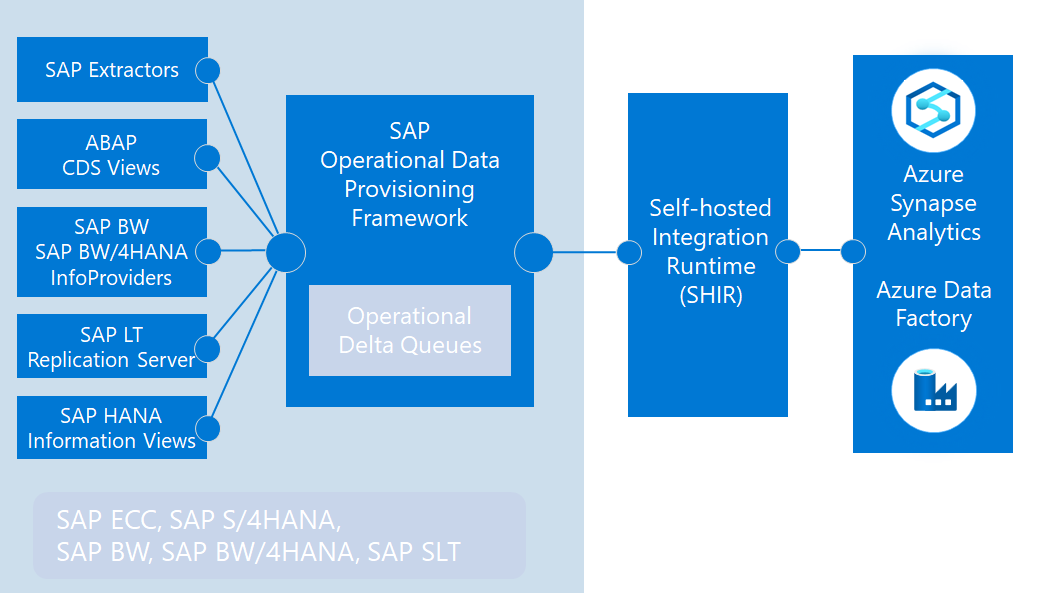

Der SAP CDC-Connector nutzt das SAP ODP-Framework, um verschiedene Datentypen zu extrahieren. Hierzu zählen:

- SAP-Extraktoren, die ursprünglich entwickelt wurden, um Daten aus SAP ECC zu extrahieren und in SAP BW zu laden

- ABAP CDS-Ansichten, der neue Datenextraktionsstandard für SAP S/4HANA

- InfoProviders- und InfoObjects-Datasets in SAP BW und SAP BW/4HANA

- SAP-Anwendungstabellen bei Verwendung eines SLT-Replikationsservers (SAP LT) als Proxy

In diesem Prozess sind die SAP-Datenquellen Anbieter. Die Anbieter werden auf SAP-Systemen ausgeführt, um vollständige oder inkrementelle Daten in einer betriebsfähigen Deltawarteschlange (ODQ) zu erstellen. Die Quelle des Zuordnungsdatenflusses ist ein Abonnent der ODQ.

Da ODP Anbieter vollständig von Abonnenten entkoppelt, sind alle SAP-Dokumente, die Anbieterkonfigurationen bieten, für Data Factory als Abonnent geeignet. Weitere Informationen zu ODP finden Sie in der Einführung in die Bereitstellung von operativen Daten.