Руководство. Запись в разностную таблицу, хранящуюся в Azure Data Lake Storage 2-го поколения (общедоступная предварительная версия)

В этом руководстве показано, как создать задание Stream Analytics для записи в таблицу Delta в Azure Data Lake Storage 2-го поколения. В этом руководстве описано следующее:

- Развертывание генератора событий, отправляющего примеры данных в концентратор событий

- Создание задания Stream Analytics

- Настройка Azure Data Lake Storage 2-го поколения с помощью разностной таблицы

- Выполнение задания Stream Analytics

Необходимые компоненты

Прежде чем начать, выполните следующие действия.

- Если у вас еще нет подписки Azure, создайте бесплатную учетную запись.

- Разверните генератор событий TollApp в Azure. Используйте эту ссылку, чтобы развернуть шаблон TollApp Azure. Установите для параметра "interval" значение 1. Создайте и используйте новую группу ресурсов для этого шага.

- Создайте учетную запись Data Lake Storage 2-го поколения.

Создание задания Stream Analytics

Войдите на портал Azure.

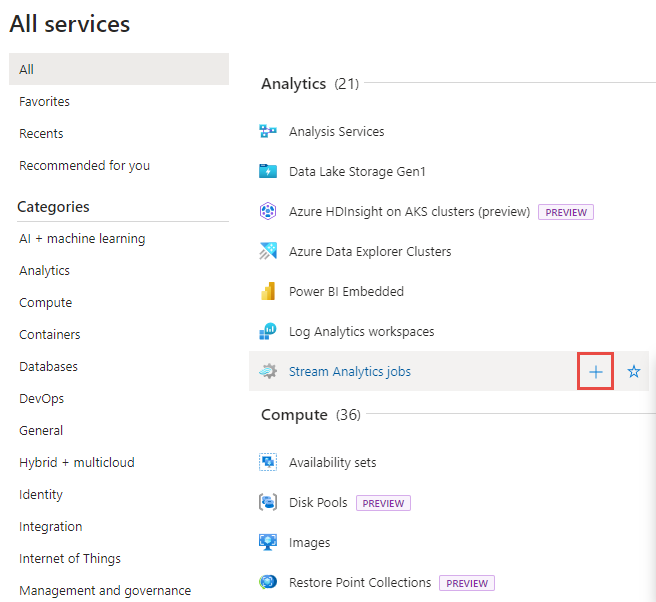

В меню слева выберите Все службы.

Переместите указатель мыши на задания Stream Analytics в разделе "Аналитика" и выберите + (плюс).

Щелкните Создать ресурс в верхнем левом углу окна портала Azure.

В списке результатов выберите Аналитика>Задание Stream Analytics.

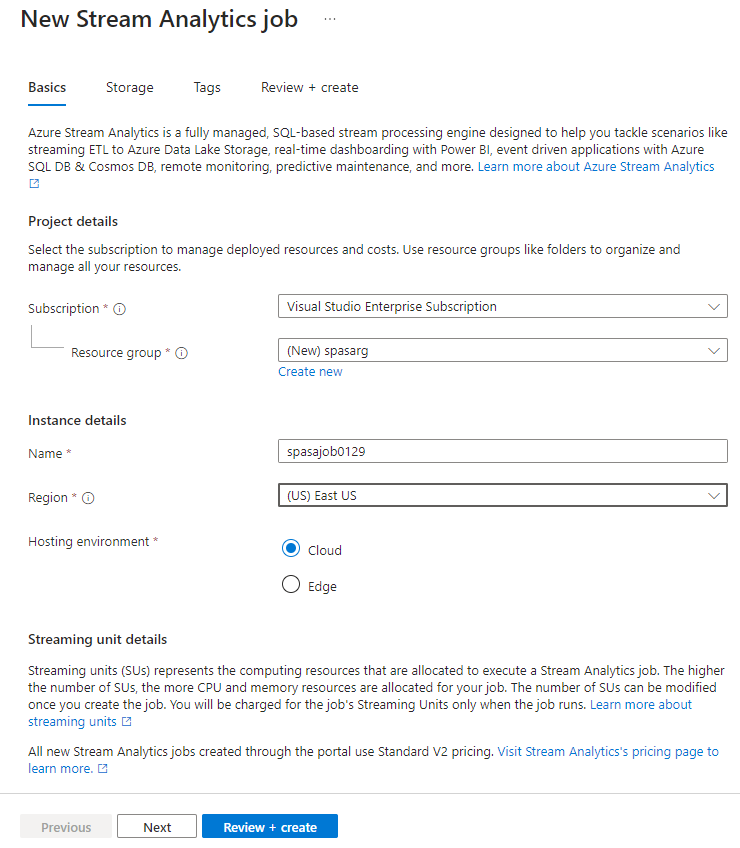

На странице Новое задание New Stream Analytics сделайте следующее:

- Подписка — выберите подписку Azure.

- Для группы ресурсов выберите тот же ресурс, который использовался ранее в развертывании TollApp.

- В качестве имени введите имя задания. Имя задания Stream Analytics может содержать только буквенно-цифровые символы, дефисы и знаки подчеркивания. Длина должна составлять от 3 до 63 символов.

- В качестве среды размещения выберите значение Облако.

- В качестве единиц потоковой передачи выберите 1. Единица потоковой передачи предоставляет вычислительные ресурсы, которые необходимы для выполнения задания. Чтобы узнать о масштабировании единиц потоковой передачи, ознакомьтесь со статьей Обзор и настройка единиц потоковой передачи.

В нижней части страницы выберите Review + create (Проверить и создать).

На странице Просмотр и создание проверьте параметры и выберите Создать, чтобы создать страницу Stream Analytics.

На странице развертывания выберите Перейти к ресурсу, чтобы перейти на страницу Задание Stream Analytics.

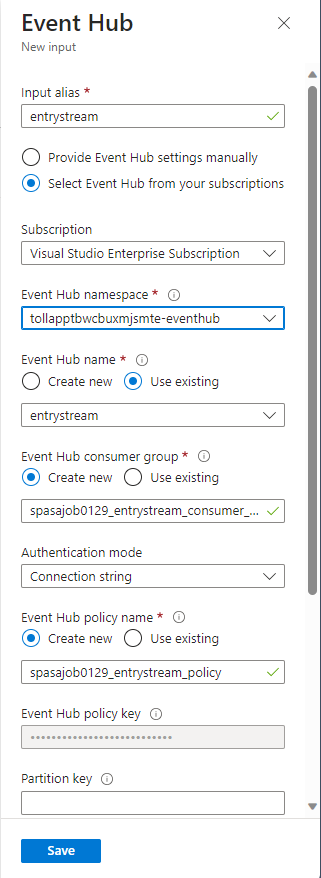

Настройка входных данных для задания

Следующим шагом является определение источника входных данных для задания для чтения данных с помощью концентратора событий, созданного в развертывании TollApp.

Найдите задание Stream Analytics, созданное в предыдущем разделе.

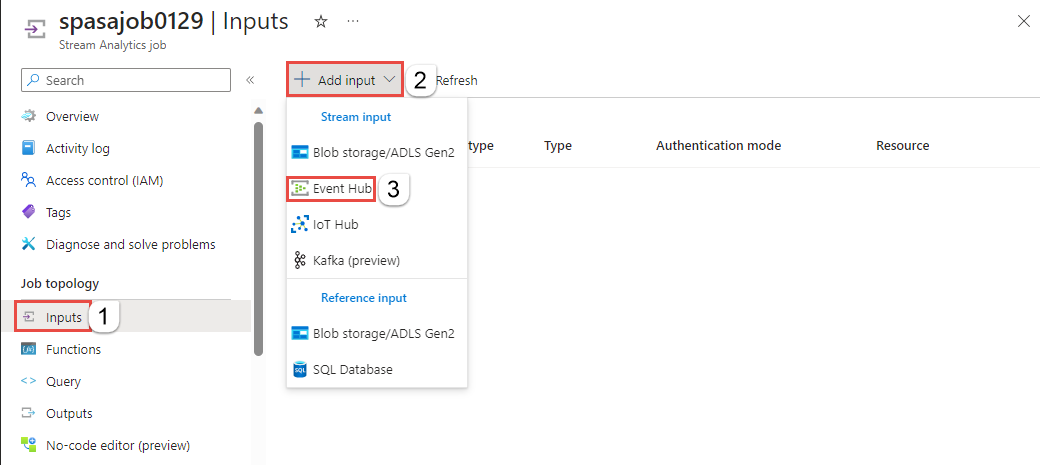

В разделе Топология задания задания Stream Analytics выберите Входные данные.

Выберите +Добавить входные данные и концентратор событий.

Заполните входную форму следующими значениями, созданными с помощью шаблона Azure TollApp:

Для псевдонима входных данных введите запись.

Выберите "Выбрать концентратор событий" из подписок.

Подписка — выберите подписку Azure.

Для пространства имен Концентратора событий выберите пространство имен концентратора событий, созданное в предыдущем разделе.

Используйте значения по умолчанию для оставшихся параметров и нажмите кнопку Сохранить.

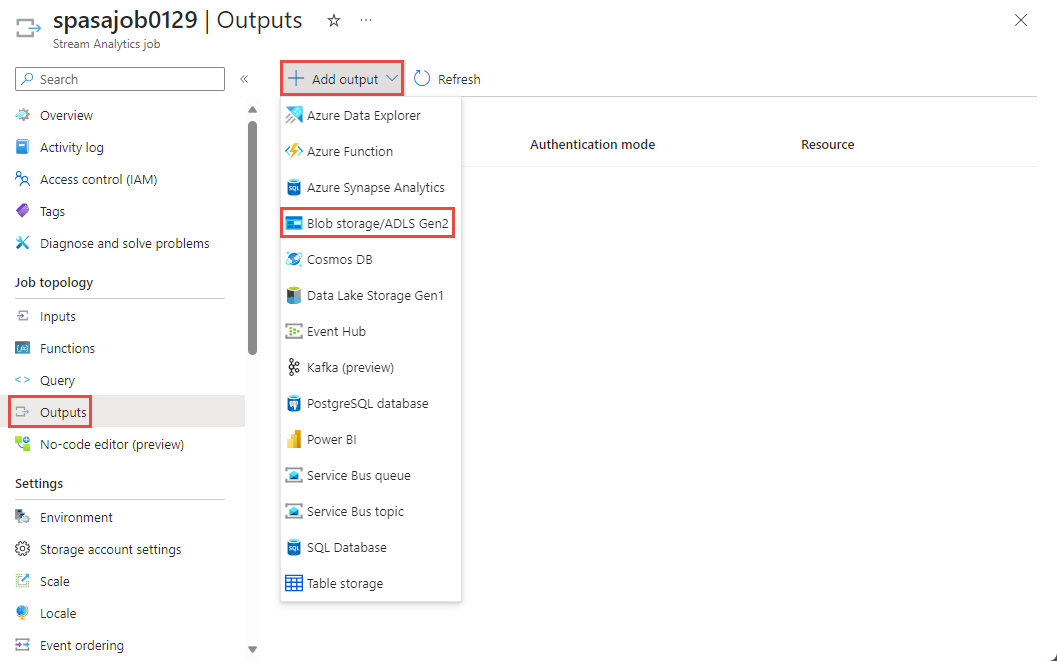

Настройка выходных данных для задания

Следующим шагом является определение приемника выходных данных, в который задание может записывать данные. В этом руководстве вы записываете выходные данные в таблицу Delta в Azure Data Lake Storage 2-го поколения.

В разделе Топология задания задания Stream Analytics выберите вариант Выходные данные.

Выберите +Добавить выходное>хранилище BLOB-объектов/ADLS 2-го поколения.

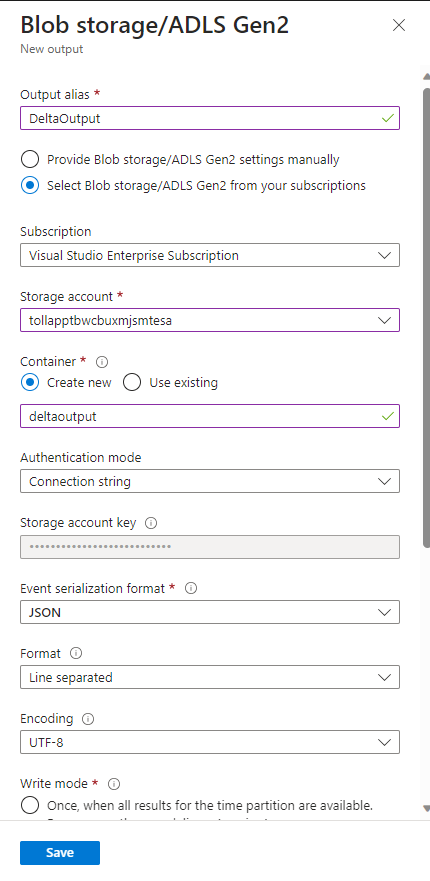

Заполните форму следующими сведениями и нажмите кнопку Сохранить:

Для псевдонима вывода введите DeltaOutput.

Выберите хранилище BLOB-объектов или ADLS 2-го поколения из подписок.

Подписка — выберите подписку Azure.

Для учетной записи служба хранилища выберите созданную учетную запись ADLS 2-го поколения (которая начинается с платных приложений).

Для контейнера выберите "Создать" и укажите уникальное имя контейнера.

Для формата сериализации событий выберите Delta Lake (предварительная версия). Хотя delta lake указан в качестве одного из вариантов здесь, это не формат данных. Delta Lake использует версии файлов Parquet для хранения данных. Дополнительные сведения о разностном озере.

Для пути к таблице Delta введите папку руководства или разностную таблицу.

Используйте значения по умолчанию для оставшихся параметров и нажмите кнопку Сохранить.

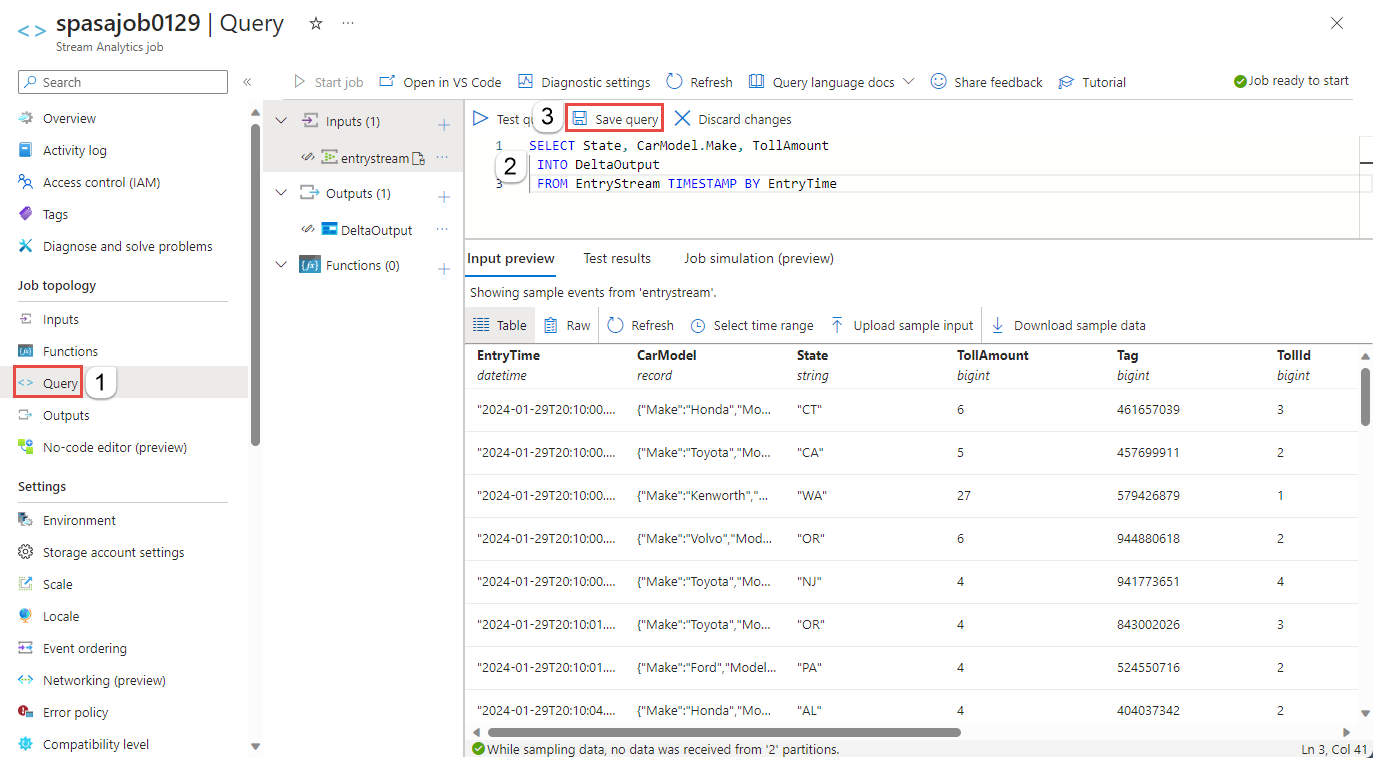

Создание запросов

На этом этапе задание Stream Analytics настроено на считывание входящего потока данных. Далее необходимо создать запрос для анализа данных в режиме реального времени. В запросах используется язык на основе SQL, который содержит некоторые расширения, характерные для Stream Analytics.

Теперь выберите Запрос в разделе Топология задания в меню слева.

Введите следующий запрос в окно запроса. В этом примере запрос считывает данные из Центров событий и копирует выбранные значения в таблицу Delta в ADLS 2-го поколения.

SELECT State, CarModel.Make, TollAmount INTO DeltaOutput FROM EntryStream TIMESTAMP BY EntryTimeНа панели инструментов выберите Сохранить запрос.

Запуск задания Stream Analytics и просмотр выходных данных

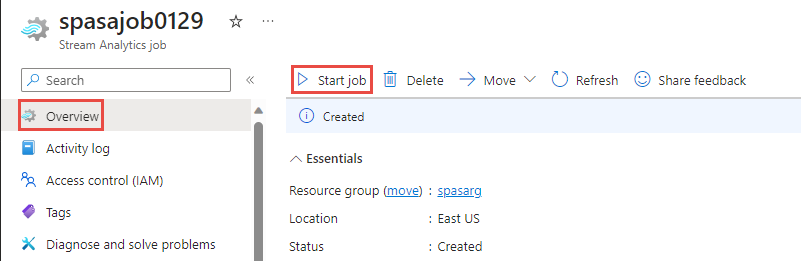

Вернитесь на страницу обзора задания на портале Azure и нажмите кнопку Запуск.

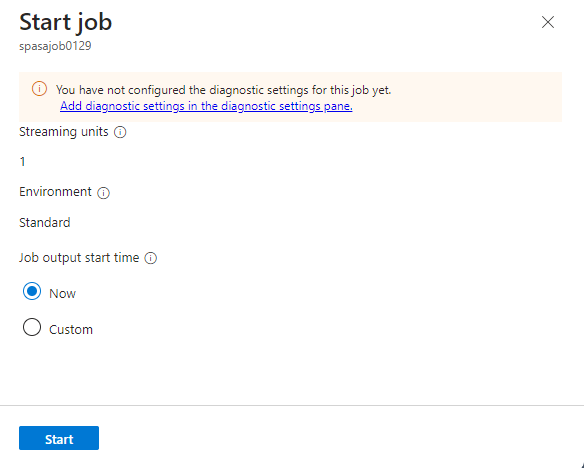

На странице начального задания убедитесь, чтовыбрано время начала выходных данных задания, а затем нажмите кнопку "Пуск" в нижней части страницы.

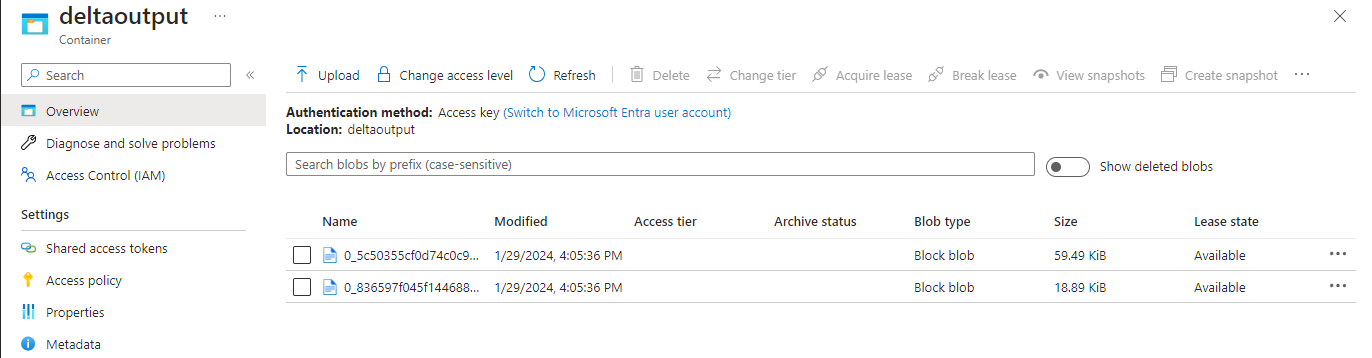

Через несколько минут на портале найдите учетную запись хранения и контейнер, настроенный в качестве выходных данных для задания. Теперь можно увидеть разностную таблицу в папке, указанной в контейнере. Задание запустится через несколько минут и после запуска будет продолжать работать по мере поступления данных.

Очистка ресурсов

Ставшие ненужными группу ресурсов, задание Stream Analytics и все связанные ресурсы можно удалить. При удалении задания будет прекращена тарификация за единицы потоковой передачи, потребляемые заданием. Если вы планируете использовать это задание в будущем, вы можете остановить и перезапустить его позже. Если вы не собираетесь продолжать использовать это задание, удалите все ресурсы, созданные этим руководством, выполнив следующие действия.

- В меню слева на портале Azure выберите Группы ресурсов, а затем выберите имя созданного ресурса.

- На странице группы ресурсов выберите Удалить, в текстовом поле введите имя ресурса для удаления и щелкните Удалить.

Следующие шаги

В этом руководстве вы создали простое задание Stream Analytics, отфильтровали входящие данные и напишите результаты в таблице Delta в учетной записи ADLS 2-го поколения. Дополнительные сведения о заданиях Stream Analytics: