Przyrostowe kopiowanie nowych i zmienionych plików na podstawie funkcji LastModifiedDate przy użyciu narzędzia do kopiowania danych

DOTYCZY: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Napiwek

Wypróbuj usługę Data Factory w usłudze Microsoft Fabric — rozwiązanie analityczne typu all-in-one dla przedsiębiorstw. Usługa Microsoft Fabric obejmuje wszystko, od przenoszenia danych do nauki o danych, analizy w czasie rzeczywistym, analizy biznesowej i raportowania. Dowiedz się, jak bezpłatnie rozpocząć nową wersję próbną !

W tym samouczku utworzysz fabrykę danych przy użyciu witryny Azure Portal. Następnie użyjesz narzędzia do kopiowania danych, aby utworzyć potok, który przyrostowo kopiuje tylko nowe i zmienione pliki z usługi Azure Blob Storage do usługi Azure Blob Storage. Używa LastModifiedDate go do określenia plików do skopiowania.

Po wykonaniu kroków opisanych w tym miejscu usługa Azure Data Factory przeskanuje wszystkie pliki w magazynie źródłowym, zastosuje filtr plików według LastModifiedDate, a następnie skopiuje do magazynu docelowego tylko pliki, które są nowe lub zostały zaktualizowane od czasu ostatniego. Należy pamiętać, że jeśli usługa Data Factory skanuje dużą liczbę plików, nadal należy oczekiwać długich czasów trwania. Skanowanie plików jest czasochłonne, nawet jeśli ilość skopiowanych danych zostanie zmniejszona.

Uwaga

Jeśli jesteś nowym użytkownikiem usługi Data Factory, zobacz Wprowadzenie do usługi Azure Data Factory.

W tym samouczku wykonasz następujące zadania:

- Tworzenie fabryki danych.

- Tworzenie potoku za pomocą narzędzia do kopiowania danych.

- Monitorowanie uruchomień potoku i działań.

Wymagania wstępne

- Subskrypcja platformy Azure: jeśli nie masz subskrypcji platformy Azure, przed rozpoczęciem utwórz bezpłatne konto.

- Konto usługi Azure Storage: użyj usługi Blob Storage dla magazynów danych źródłowych i ujścia. Jeśli nie masz konta usługi Azure Storage, postępuj zgodnie z instrukcjami w temacie Tworzenie konta magazynu.

Tworzenie dwóch kontenerów w usłudze Blob Storage

Przygotuj magazyn obiektów blob na potrzeby samouczka, wykonując następujące czynności:

Utwórz kontener o nazwie source. Do wykonania tego zadania można użyć różnych narzędzi, takich jak Eksplorator usługi Azure Storage.

Utwórz kontener o nazwie destination.

Tworzenie fabryki danych

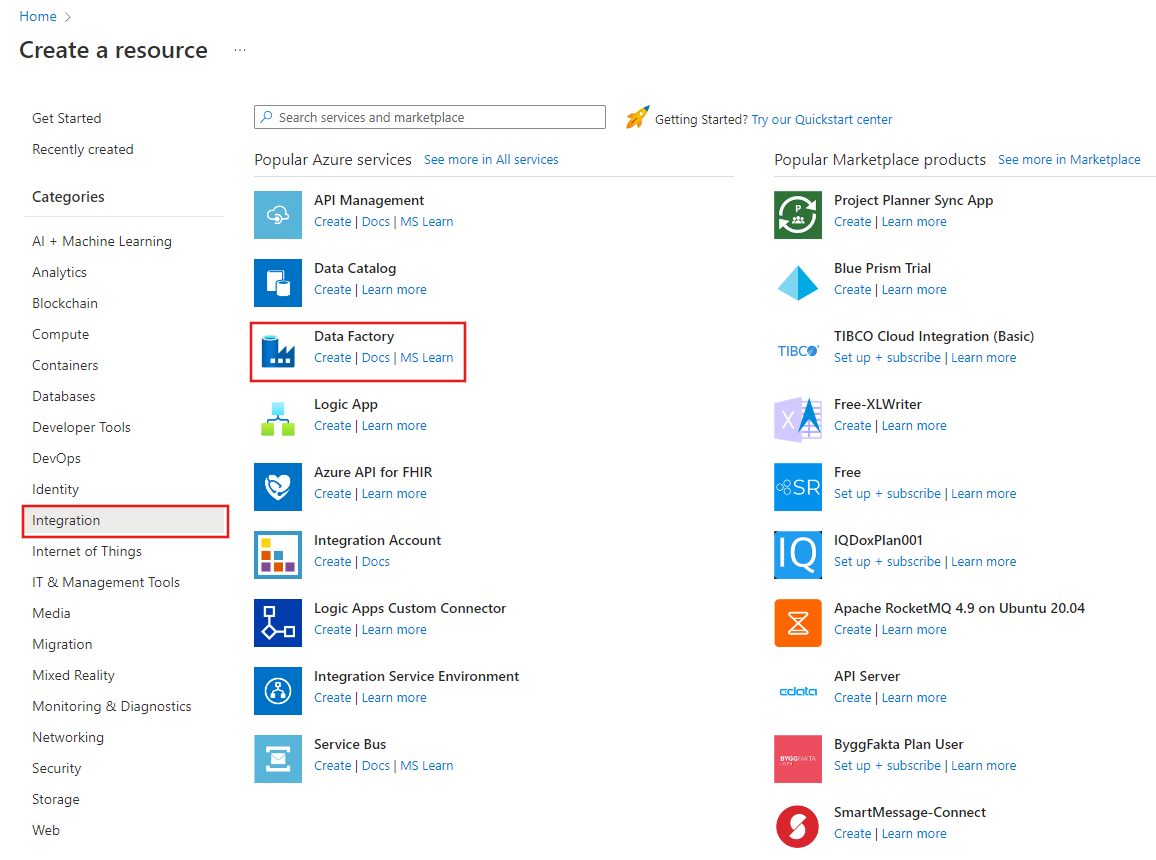

W okienku po lewej stronie wybierz pozycję Utwórz zasób. Wybierz pozycję Integracja z usługą>Data Factory:

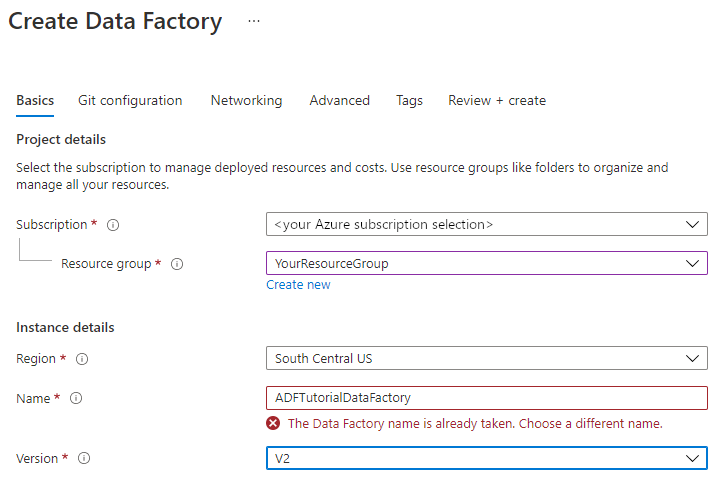

Na stronie Nowa fabryka danych w polu Nazwa wprowadź wartość ADFTutorialDataFactory.

Nazwa Twojej fabryki danych musi być globalnie unikatowa. Może zostać wyświetlony następujący komunikat o błędzie:

Jeśli zostanie wyświetlony komunikat o błędzie dotyczącym wartości nazwy, wprowadź inną nazwę dla fabryki danych. Na przykład użyj nazwy twojanazwaADFTutorialDataFactory. Artykuł Data Factory naming rules (Zasady nazewnictwa fabryki danych) zawiera zasady nazewnictwa artefaktów usługi Data Factory.

W obszarze Subskrypcja wybierz subskrypcję platformy Azure, w której utworzysz nową fabrykę danych.

W obszarze Grupa zasobów wykonaj jedną z następujących czynności:

Wybierz pozycję Użyj istniejącej , a następnie wybierz istniejącą grupę zasobów na liście.

Wybierz pozycję Utwórz nową , a następnie wprowadź nazwę grupy zasobów.

Informacje na temat grup zasobów znajdują się w artykule Using resource groups to manage your Azure resources (Używanie grup zasobów do zarządzania zasobami platformy Azure).

W obszarze Wersja wybierz pozycję V2.

W obszarze Lokalizacja wybierz lokalizację fabryki danych. Na liście są wyświetlane tylko obsługiwane lokalizacje. Magazyny danych (na przykład Usługi Azure Storage i Azure SQL Database) i obliczenia (na przykład Usługa Azure HDInsight), których używa fabryka danych, mogą znajdować się w innych lokalizacjach i regionach.

Wybierz pozycję Utwórz.

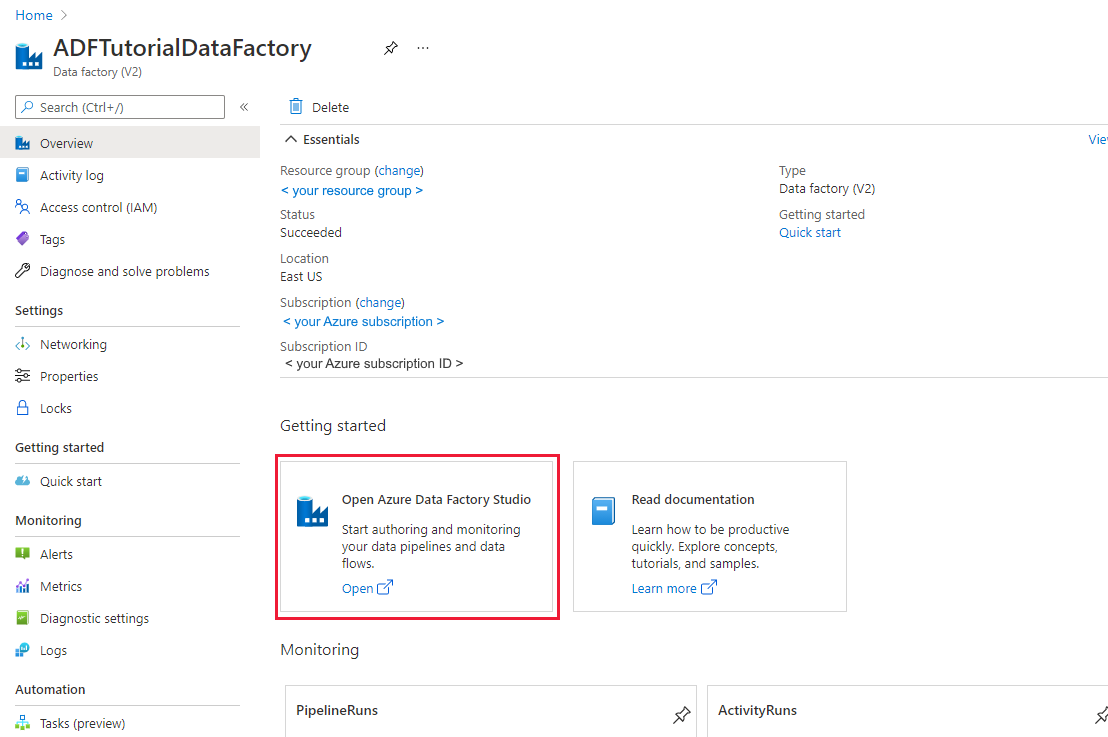

Po utworzeniu fabryki danych zostanie wyświetlona strona główna fabryki danych.

Aby otworzyć interfejs użytkownika usługi Azure Data Factory na osobnej karcie, wybierz pozycję Otwórz na kafelku Otwórz usługę Azure Data Factory Studio :

Tworzenie potoku za pomocą narzędzia do kopiowania danych

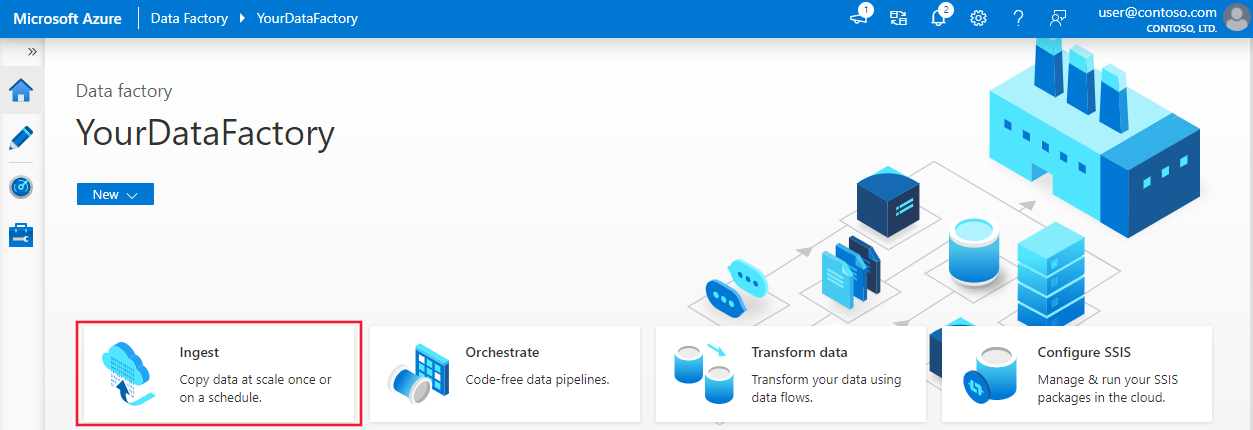

Na stronie głównej usługi Azure Data Factory wybierz kafelek Pozyskiwanie , aby otworzyć narzędzie do kopiowania danych:

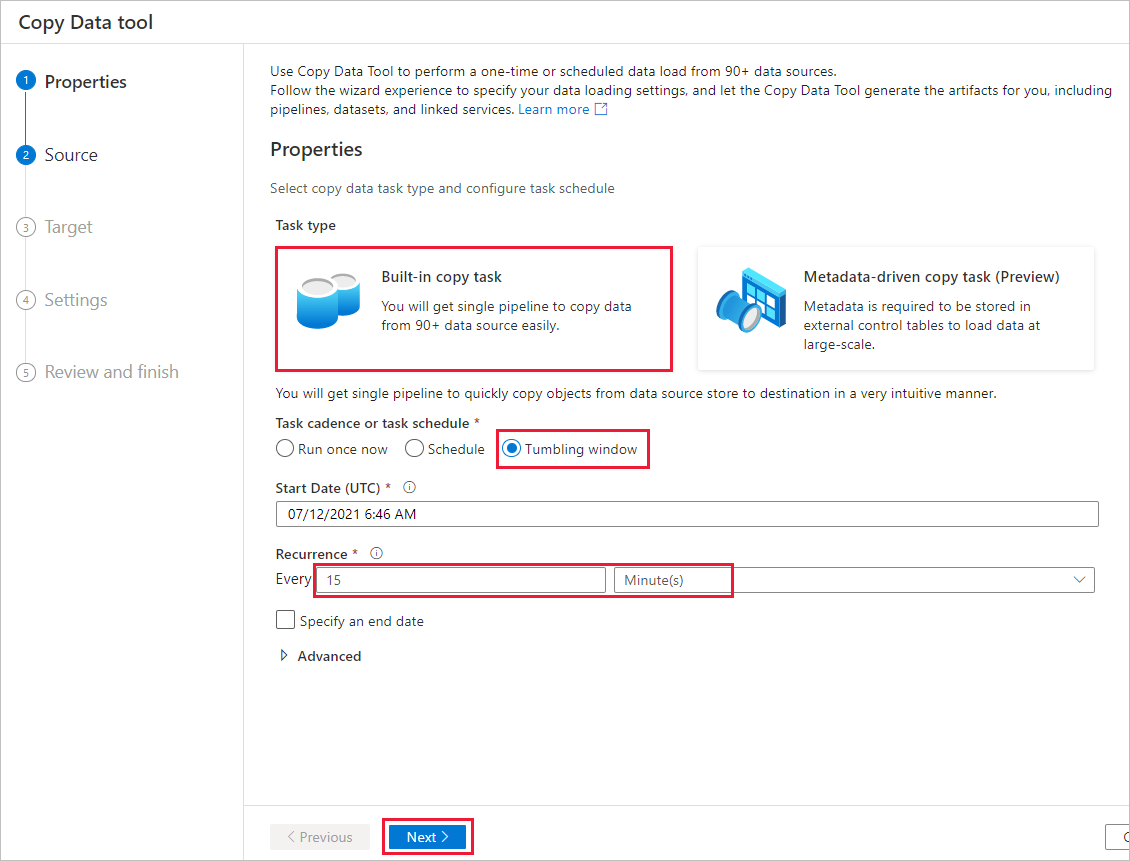

Na stronie Właściwości wykonaj następujące czynności:

W obszarze Typ zadania wybierz pozycję Wbudowane zadanie kopiowania.

W obszarze Harmonogram zadań lub harmonogram zadań wybierz pozycję Okno wirowania.

W obszarze Cykl wprowadź wartość 15 minut.

Wybierz Dalej.

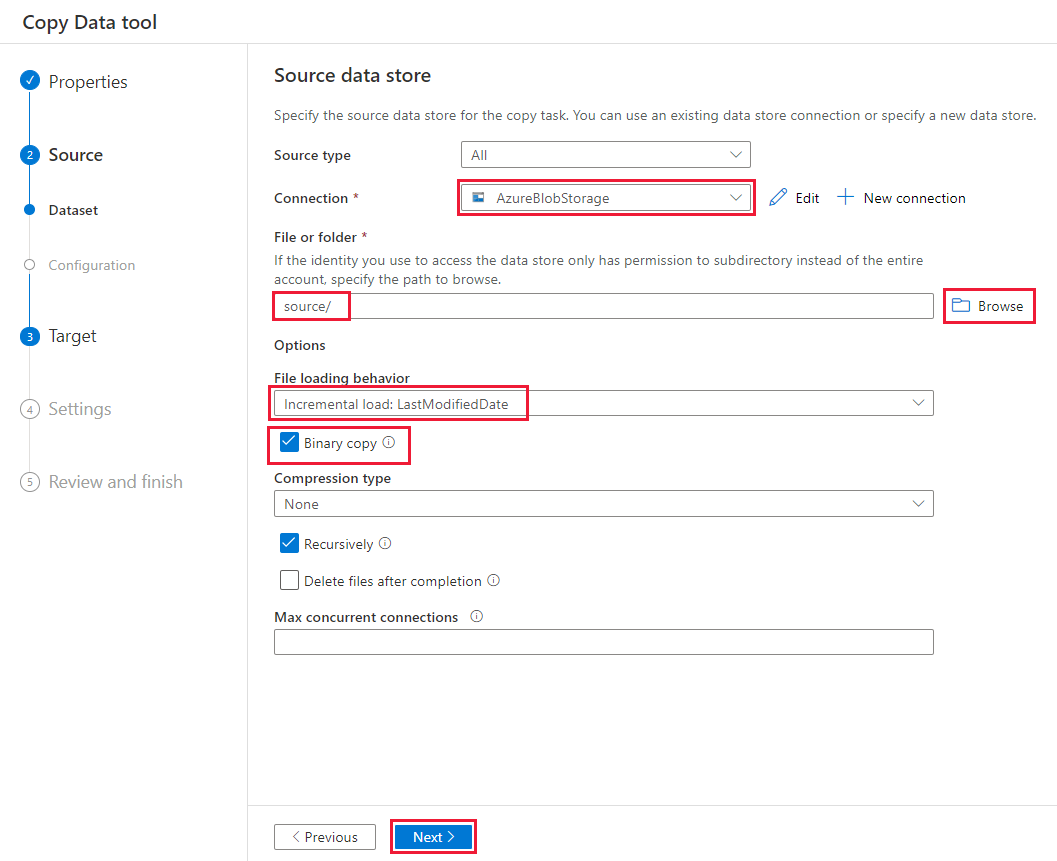

Na stronie Źródłowy magazyn danych wykonaj następujące kroki:

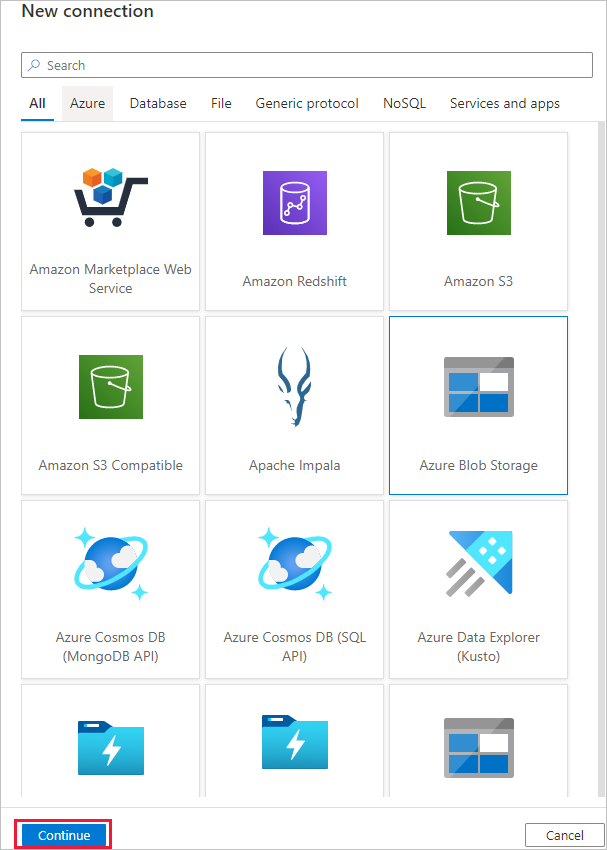

Wybierz pozycję + Nowe połączenie , aby dodać połączenie.

Wybierz pozycję Azure Blob Storage z galerii, a następnie wybierz pozycję Kontynuuj:

Na stronie Nowe połączenie (Azure Blob Storage) wybierz swoją subskrypcję platformy Azure z listy subskrypcji platformy Azure i konto magazynu z listy Nazwa konta usługi Storage. Przetestuj połączenie, a następnie wybierz pozycję Utwórz.

Wybierz nowo utworzone połączenie w bloku Połączenie ion.

W sekcji Plik lub folder wybierz pozycję Przeglądaj i wybierz folder źródłowy, a następnie wybierz przycisk OK.

W obszarze Zachowanie ładowania pliku wybierz pozycję Ładowanie przyrostowe: LastModifiedDate i wybierz pozycję Kopia binarna.

Wybierz Dalej.

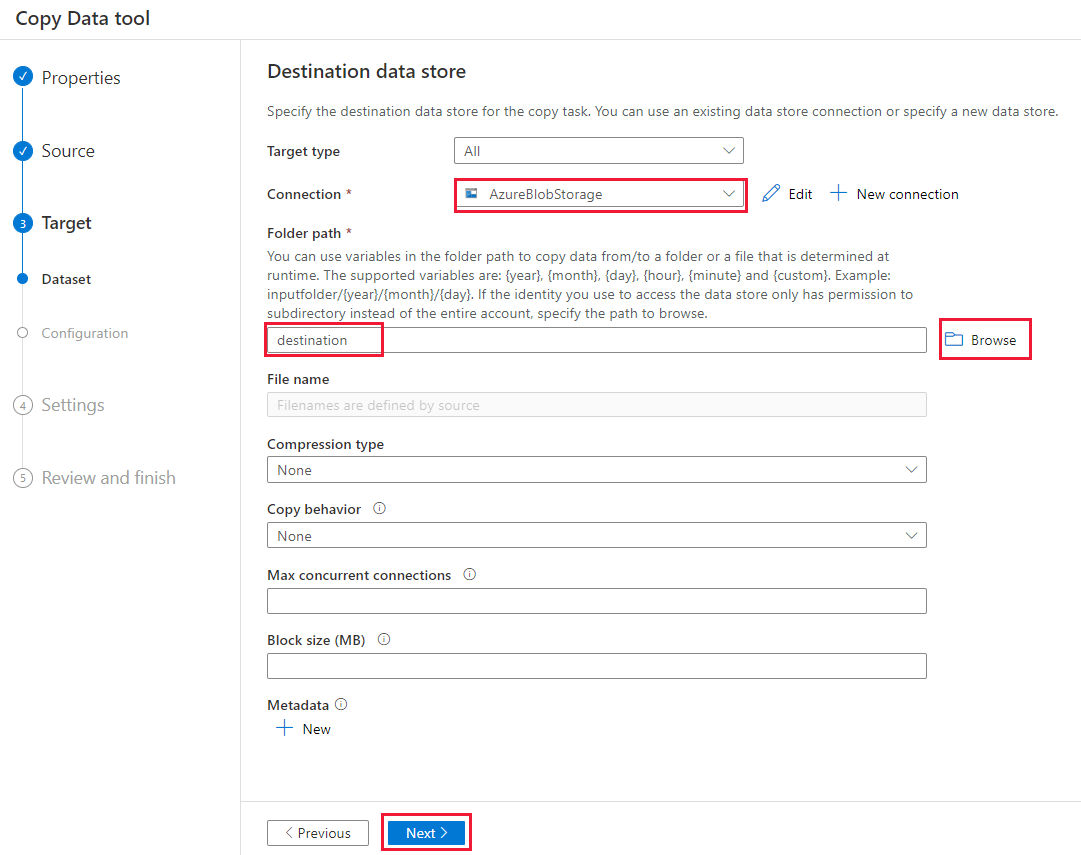

Na stronie Docelowy magazyn danych wykonaj następujące kroki:

Wybierz utworzone połączenie AzureBlobStorage. Jest to to samo konto magazynu co źródłowy magazyn danych.

W sekcji Ścieżka folderu wyszukaj i wybierz folder docelowy, a następnie wybierz przycisk OK.

Wybierz Dalej.

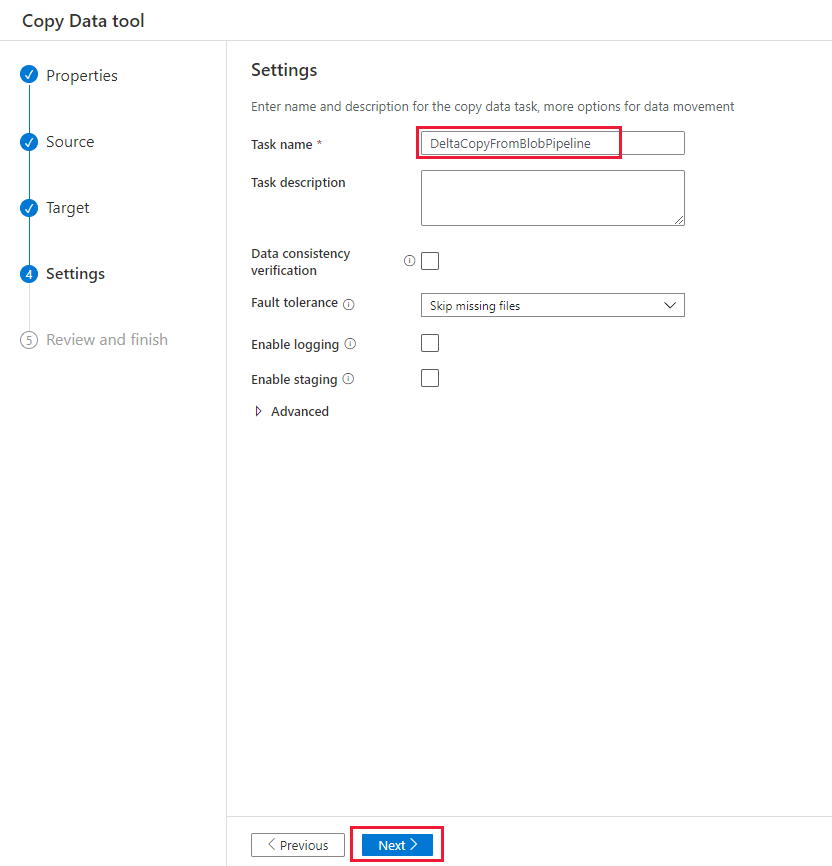

Na stronie Ustawienia w obszarze Nazwa zadania wprowadź ciąg DeltaCopyFromBlobPipeline, a następnie wybierz przycisk Dalej. Usługa Data Factory tworzy potok o określonej nazwie zadania.

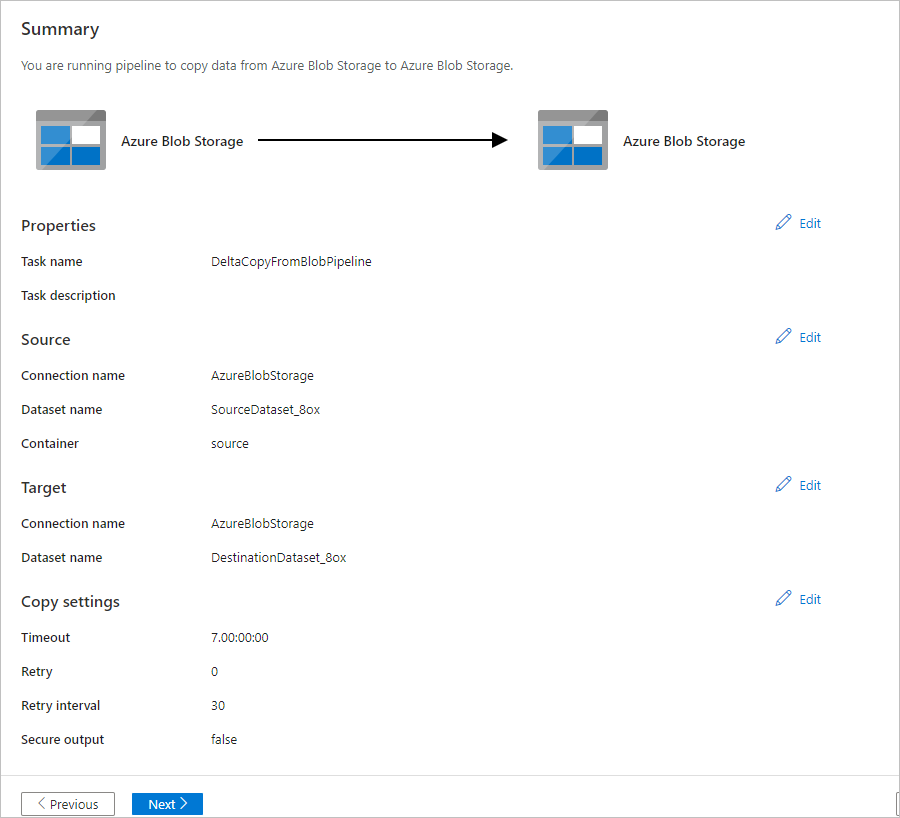

Na stronie Podsumowanie przejrzyj ustawienia, a następnie wybierz pozycję Dalej.

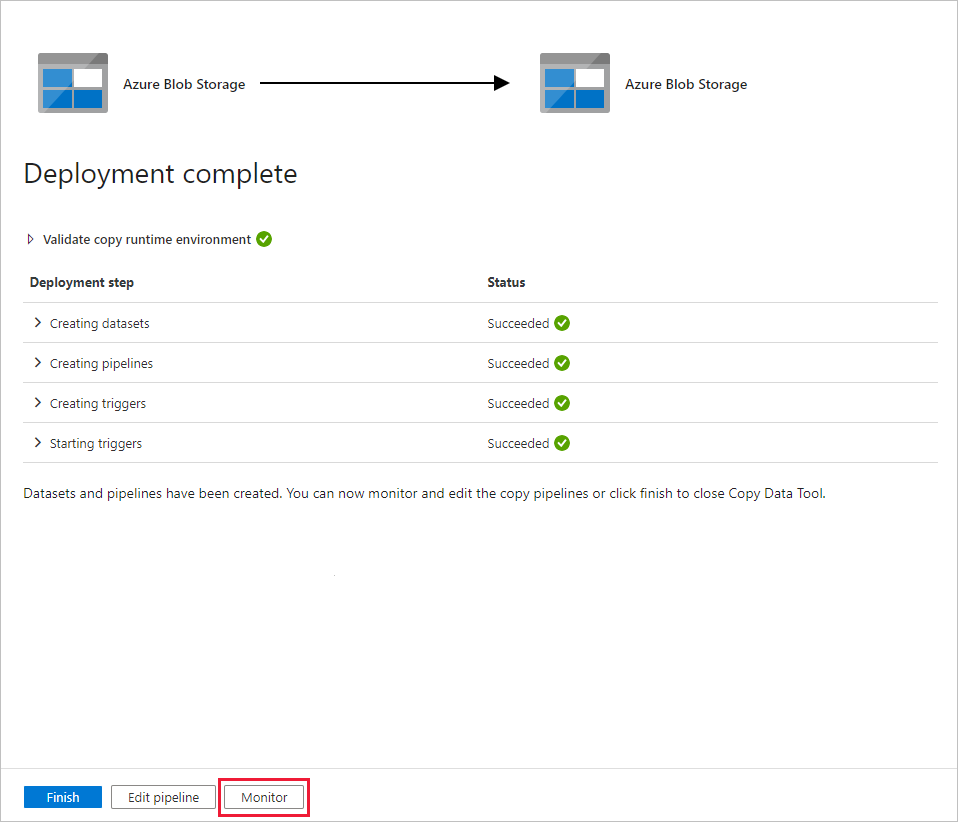

Na stronie Wdrażanie wybierz pozycję Monitorowanie, aby monitorować potok (zadanie).

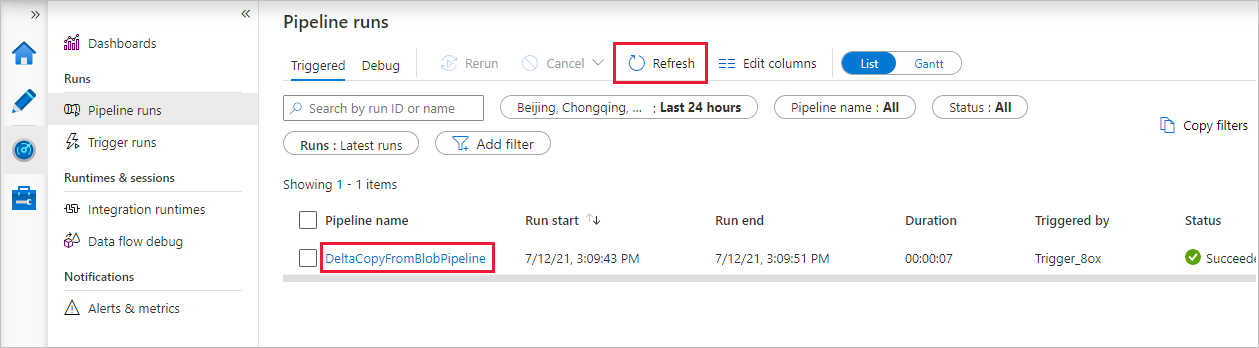

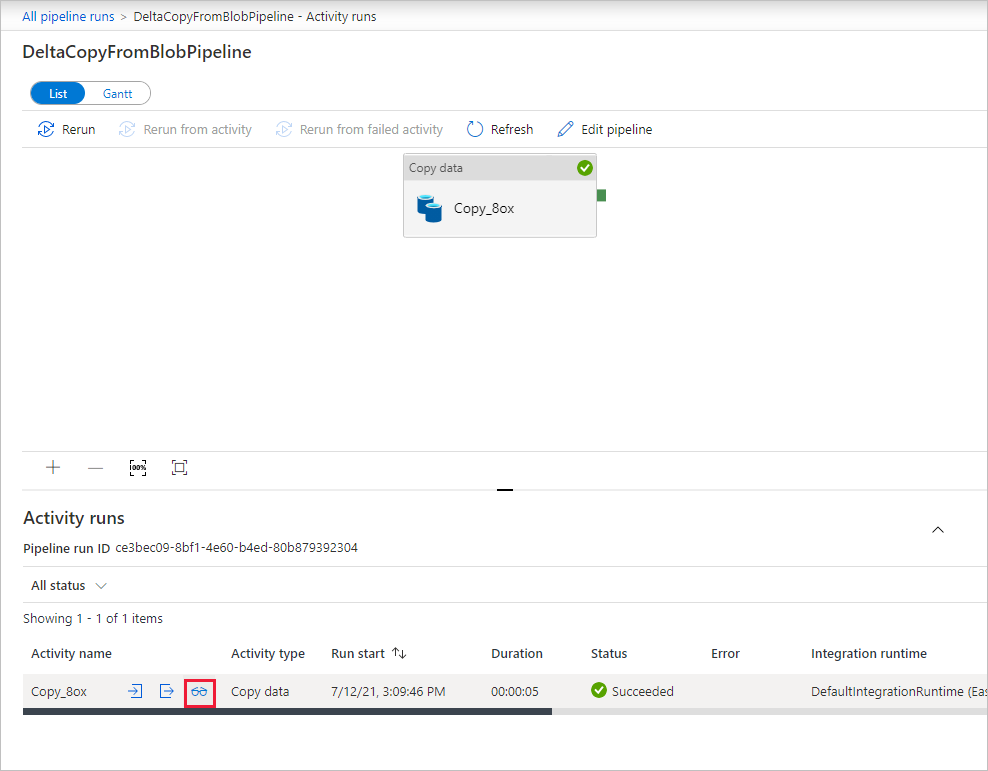

Zwróć uwagę, że karta Monitor po lewej stronie jest automatycznie wybrana. Aplikacja przełącza się na kartę Monitorowanie . Zostanie wyświetlony stan potoku. Wybierz pozycję Odśwież, aby odświeżyć listę. Wybierz link w obszarze Nazwa potoku, aby wyświetlić szczegóły uruchomienia działania lub ponownie uruchomić potok.

W potoku istnieje tylko jedno działanie (działanie kopiowania), więc zobaczysz tylko jeden wpis. Aby uzyskać szczegółowe informacje na temat operacji kopiowania, na stronie Uruchomienia działania wybierz link Szczegóły (ikona okularów) w kolumnie Nazwa działania. Aby uzyskać szczegółowe informacje o właściwościach, zobacz działanie Kopiuj omówienie.

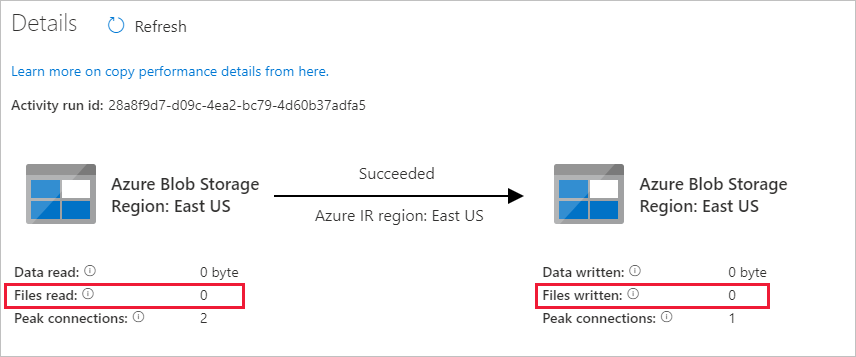

Ponieważ na koncie usługi Blob Storage nie ma żadnych plików w kontenerze źródłowym, nie zobaczysz żadnych plików skopiowanych do kontenera docelowego na koncie:

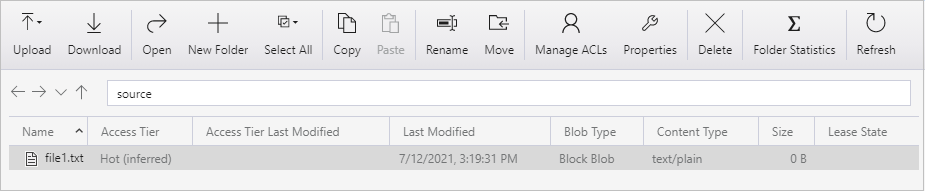

Utwórz pusty plik tekstowy i nadaj mu nazwę file1.txt. Przekaż ten plik tekstowy do kontenera źródłowego na koncie magazynu. Możesz użyć różnych narzędzi do wykonywania tych zadań, takich jak Eksplorator usługi Azure Storage.

Aby wrócić do widoku Uruchomienia potoku, wybierz link Wszystkie uruchomienia potoku w menu linku do stron nadrzędnych na stronie Uruchomienia działania i poczekaj na automatyczne wyzwolenie tego samego potoku.

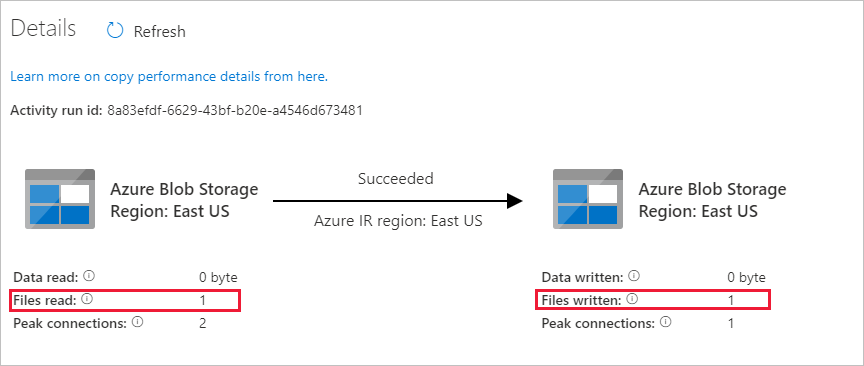

Po zakończeniu drugiego uruchomienia potoku wykonaj te same kroki, o których wspomniano wcześniej, aby przejrzeć szczegóły przebiegu działania.

Zobaczysz, że jeden plik (plik1.txt) został skopiowany z kontenera źródłowego do kontenera docelowego konta usługi Blob Storage:

Utwórz kolejny pusty plik tekstowy i nadaj mu nazwę file2.txt. Przekaż ten plik tekstowy do kontenera źródłowego na koncie usługi Blob Storage.

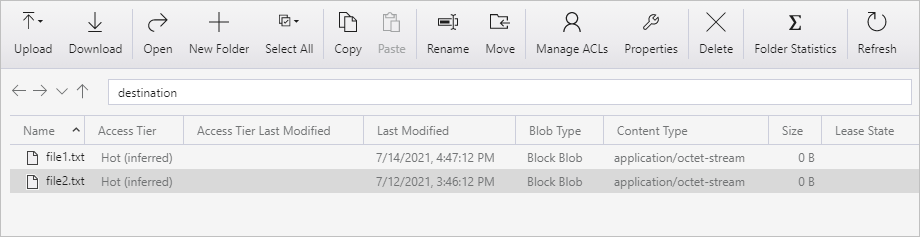

Powtórz kroki 11 i 12 dla drugiego pliku tekstowego. Zobaczysz, że podczas tego uruchomienia potoku skopiowano tylko nowy plik (file2.txt) z kontenera źródłowego do kontenera docelowego konta magazynu.

Możesz również sprawdzić, czy skopiowano tylko jeden plik, używając Eksplorator usługi Azure Storage do skanowania plików:

Powiązana zawartość

Przejdź do następującego samouczka, aby dowiedzieć się, jak przekształcać dane przy użyciu klastra Apache Spark na platformie Azure: